轻松部署DeepSeek R1智能对话系统:本地搭建与联网功能实践

我实际操作发现其内置的AI辅助功能很实用,能自动补全很多配置细节,一键部署过程也很流畅,特别适合想快速体验AI模型能力的开发者。模型下载环节需要从Hugging Face获取授权,通过snapshot_download工具可以自动处理依赖关系和分片下载,比手动下载更可靠。创建Python虚拟环境时,建议使用conda管理工具,安装指定版本的PyTorch和Transformers库。创建基础服务时

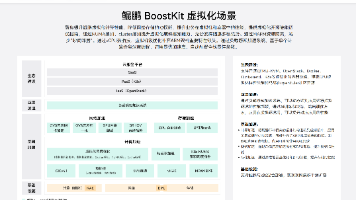

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框输入如下内容

帮我开发一个DeepSeek R1智能对话系统,帮开发者和企业快速搭建本地AI助手并实现联网功能。系统交互细节:1.支持本地模型部署 2.集成网络搜索API 3.提供安全接口调用 4.包含性能优化配置。注意事项:需要准备GPU环境和API密钥。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

环境准备与核心部署

-

DeepSeek R1部署需要区分GPU和CPU两种运行环境。对于GPU环境推荐使用NVIDIA RTX 3090及以上显卡,搭配32GB内存;CPU环境则需要支持AVX2指令集,16GB内存是最低要求。

-

创建Python虚拟环境时,建议使用conda管理工具,安装指定版本的PyTorch和Transformers库。特别注意要匹配CUDA版本与显卡驱动,这是很多新手容易出错的地方。

-

模型下载环节需要从Hugging Face获取授权,通过snapshot_download工具可以自动处理依赖关系和分片下载,比手动下载更可靠。建议设置max_workers参数加速下载过程。

服务搭建关键步骤

-

FastAPI框架是部署AI服务的理想选择,它轻量高效且支持异步处理。创建基础服务时,要注意device_map参数的设置,这决定了模型如何分配到可用设备上。

-

生成响应时温度参数(temperature)和top_p采样策略需要根据场景调整。对话类应用通常设为0.7-0.9之间,太高会导致回答随机性过强。

-

实现联网功能需要设计独立的网络访问层,建议使用requests库配合BeautifulSoup解析网页。为提升效率,可以考虑加入缓存机制避免重复请求相同内容。

安全优化与监控

-

添加HTTPS中间件和可信主机验证是基础安全措施。X-Content-Type-Options和X-Frame-Options等响应头能有效防御常见Web攻击。

-

模型量化技术可以大幅减少内存占用,4bit量化能在几乎不损失精度的情况下将模型体积缩小4倍。Flash Attention的启用能进一步提升推理速度。

-

集成Prometheus监控可以实时掌握服务状态,配合日志轮转机制能有效管理服务产生的数据。建议设置日志级别为INFO以上,便于问题排查。

实际应用建议

-

联网功能实现时,建议对用户查询做关键词提取和意图识别,避免不必要的网络请求。可以设置白名单限制可访问的域名。

-

生产环境部署要考虑负载均衡和自动扩展,可以使用Docker容器化技术简化部署流程。UVicorn的work参数可以根据CPU核心数设置。

-

对于高频查询可以引入Redis缓存,将模型输出结果缓存一段时间,显著降低计算资源消耗。

平台体验

使用InsCode(快马)平台可以快速验证这个项目,无需手动配置复杂环境。我实际操作发现其内置的AI辅助功能很实用,能自动补全很多配置细节,一键部署过程也很流畅,特别适合想快速体验AI模型能力的开发者。平台提供的资源监控功能还能直观查看服务运行状态,省去了自己搭建监控系统的麻烦。

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)