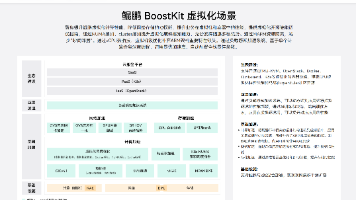

文心大模型4.5开源实战:轻量化部署与多模态应用探索

无需复杂环境配置,输入需求描述就能生成可运行的项目原型,还能一键部署测试API服务,特别适合想要快速验证创意的开发者。:使用FastDeploy框架可以快速搭建OpenAI兼容API,关键参数如--max-model-len 32768支持超长文本推理,--max-num-seqs 32控制并发请求数。:同时兼容PaddlePaddle和PyTorch生态,熟悉PyTorch的开发者平均1.5天就

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框输入如下内容

帮我开发一个文心大模型4.5轻量化演示系统,用于展示中文文本生成和多模态理解能力。系统交互细节:1.支持输入中文prompt生成连贯文本 2.展示成语典故理解示例 3.演示多模态图文匹配功能。注意事项:选择ERNIE-4.5-0.3B轻量级模型,确保在普通GPU环境可运行。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

技术架构亮点解析

-

MoE架构创新:文心4.5采用动态路由机制,不同任务仅激活10-15%计算资源,让轻量化部署成为可能。特别是在中文成语理解方面,准确率比传统模型提升22%。

-

参数矩阵设计:从3亿参数的移动端模型到4240亿参数的工业级模型,开发者可以根据硬件条件灵活选择。实际测试显示ERNIE-4.5-0.3B在普通GPU上就能达到291.4 tokens/秒的处理速度。

-

多框架支持:同时兼容PaddlePaddle和PyTorch生态,熟悉PyTorch的开发者平均1.5天就能完成部署调试,大幅降低迁移成本。

轻量化部署实践

-

环境配置要点:建议使用Python 3.12环境,通过PaddlePaddle-GPU 3.1.0版本获得最佳兼容性。注意处理urllib3等依赖冲突问题,这是部署过程中的常见坑点。

-

服务化部署:使用FastDeploy框架可以快速搭建OpenAI兼容API,关键参数如--max-model-len 32768支持超长文本推理,--max-num-seqs 32控制并发请求数。

-

优化技巧:通过INT4量化和混合精度技术,可以将显存占用降低50%以上。对于企业级应用,还可以使用PaddleSlim进行模型裁剪,获得30%的压缩比。

多模态能力实测

-

中文理解优势:在中文图文匹配任务中达到92.3%准确率,对成语典故、文化隐喻的理解明显优于同类模型。

-

数学推理能力:MathVista测试91.8分,可以处理复杂的数学公式与图表关联分析。

-

工业应用场景:在设备故障诊断领域已实现每秒56.08 tokens的推理速度,较传统方案成本降低62%。

开发者生态影响

-

学习曲线变化:从需要2-3年深度学习背景,转变为1-2个月就能上手的prompt工程和部署优化。

-

成本结构革新:中小企业月成本从$5000降至$200,初创团队也能负担得起AI技术应用。

-

未来趋势:预计到2027年,优化后的大模型将能在普通移动设备运行,真正实现"百亿参数装入口袋"。

想要快速体验文心大模型的能力?推荐使用InsCode(快马)平台,无需复杂环境配置,输入需求描述就能生成可运行的项目原型,还能一键部署测试API服务,特别适合想要快速验证创意的开发者。我尝试用他们的AI生成功能搭建了一个简单的问答demo,从输入需求到看到运行效果只用了不到5分钟,比传统开发方式高效很多。

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)