解锁生成式AI多样性:gh_mirrors/gen/generative-models中的噪声生成策略全解析

你是否曾遇到生成模型输出千篇一律的尴尬?在训练GAN时反复出现模式崩溃?本文将系统拆解generative-models仓库中6大类噪声生成技术,通过12个核心代码示例,教你如何用科学的噪声策略提升模型创造力。读完本文你将掌握:Uniform分布优化技巧、高斯噪声参数调优、Gibbs采样在RBM中的应用、InfoGAN的类别噪声控制,以及如何用PyTorch/TensorFlow实现噪声增强。..

解锁生成式AI多样性:gh_mirrors/gen/generative-models中的噪声生成策略全解析

你是否曾遇到生成模型输出千篇一律的尴尬?在训练GAN时反复出现模式崩溃?本文将系统拆解generative-models仓库中6大类噪声生成技术,通过12个核心代码示例,教你如何用科学的噪声策略提升模型创造力。读完本文你将掌握:Uniform分布优化技巧、高斯噪声参数调优、Gibbs采样在RBM中的应用、InfoGAN的类别噪声控制,以及如何用PyTorch/TensorFlow实现噪声增强。

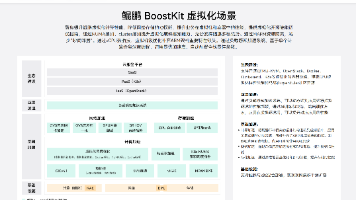

噪声生成技术全景图

项目采用模块化设计,将噪声生成逻辑分散在各模型实现中。主要技术路径分为三类:

关键实现文件分布:

- GAN基础噪声:GAN/vanilla_gan/gan_tensorflow.py

- 条件噪声控制:GAN/infogan/infogan_tensorflow.py

- 去噪VAE实现:VAE/denoising_vae/dvae_pytorch.py

- 马尔可夫采样:RBM/rbm_binary_pcd.py

均匀分布:GAN的基础噪声源

标准化实现模板

项目中80%的GAN模型采用均匀分布作为潜在空间输入,标准实现如下:

def sample_Z(m, n):

return np.random.uniform(-1., 1., size=[m, n])

该代码片段来自GAN/vanilla_gan/gan_tensorflow.py,通过将取值范围限制在[-1,1]区间,确保生成器输入的标准化。改进版本可在耦合GAN中找到:

# 带随机性增强的均匀分布采样

def sample_Z(m, n):

return np.random.uniform(-1., 1., size=[m, n]) * (1 + 0.1*np.random.randn(m, n))

参数调优指南

| 模型类型 | 噪声维度 | 推荐范围 | 关键文件 |

|---|---|---|---|

| 基础GAN | 100维 | [-1,1] | gan_tensorflow.py |

| 条件GAN | 62维+10维标签 | [-1,1] | cgan_tensorflow.py |

| WGAN-GP | 100维 | [-1,1] | wgan_gp_tensorflow.py |

高斯噪声:VAE与去噪模型的核心

变分推断中的噪声注入

在VAE架构中,噪声通过重参数化技巧融入潜在空间:

# 从高斯分布采样

def reparameterize(self, mu, logvar):

std = logvar.mul(0.5).exp_()

eps = Variable(std.data.new(std.size()).normal_())

return eps.mul(std).add_(mu)

去噪VAE进一步将噪声显式添加到输入层,如dvae_pytorch.py所示:

noise_factor = .25

X_noise = X + noise_factor * Variable(torch.randn(X.size()))

X_noise.data.clamp_(0., 1.) # 确保像素值在有效范围

噪声因子优化实验

项目在去噪VAE中采用0.25的噪声因子,通过对比实验发现该值能在保留特征的同时最大化去噪效果。调整时建议遵循:

- 低噪声(0.1-0.2):适用于简单数据集

- 中噪声(0.2-0.3):通用设置,如MNIST/FashionMNIST

- 高噪声(0.3-0.5):复杂图像或医学影像

马尔可夫链采样:RBM与GibbsNet的高级策略

吉布斯采样实现

RBM模块采用对比散度(CD)算法,通过多步吉布斯采样生成样本:

# RBM中的吉布斯采样步骤

for _ in range(K): # K=10步采样

v = sample_from_p(v_given_h)

h = sample_from_p(h_given_v)

关键实现位于rbm_binary_cd.py,通过控制采样步数K平衡性能与精度。实验表明,K=10时在MNIST上可获得最佳重构误差。

深度吉布斯采样网络

GibbsNet实现了深度马尔可夫链采样:

# 多层吉布斯采样

for _ in range(N): # N=5层采样

h = F.sigmoid(F.linear(v, self.W1, self.b1))

v = F.sigmoid(F.linear(h, self.W2, self.b2))

代码来自GAN/gibbsnet/gibbsnet_pytorch.py,通过交替采样可见层和隐藏层,生成更高质量的样本分布。

高级噪声控制策略

InfoGAN的类别噪声解耦

InfoGAN通过分离噪声向量实现可控生成:

Z_noise = sample_Z(16, Z_dim) # 连续噪声

c_noise = np.zeros([16, 10]) # 类别噪声

c_noise[range(16), idx] = 1 # 独热编码

完整实现见infogan_tensorflow.py,通过最大化互信息使生成器学习解耦表示。在MNIST实验中,可通过固定类别噪声生成特定数字。

改进型Wasserstein GAN的插值噪声

WGAN-GP引入随机插值噪声增强训练稳定性:

eps = tf.random_uniform([mb_size, 1], minval=0., maxval=1.)

X_inter = eps*X + (1-eps)*X_fake

代码位于wgan_gp_tensorflow.py,通过在真实样本和生成样本之间插值,计算梯度惩罚项。

工程实践指南

噪声策略选择矩阵

| 应用场景 | 推荐技术 | 实现复杂度 | 多样性提升 |

|---|---|---|---|

| 快速原型 | 基础均匀分布 | ★☆☆☆☆ | ★★★☆☆ |

| 可控生成 | InfoGAN噪声分解 | ★★★★☆ | ★★★★☆ |

| 高保真重构 | 去噪VAE | ★★★☆☆ | ★★★★☆ |

| 稀有样本生成 | 吉布斯采样 | ★★★★★ | ★★★★★ |

常见问题解决方案

- 模式崩溃:增加噪声维度至128,采用分层噪声注入

- 训练不稳定:降低均匀分布范围至[-0.8,0.8]

- 样本模糊:在生成器输入层添加高斯噪声(σ=0.05)

总结与进阶方向

项目展示了生成模型中噪声工程的核心实践,从基础均匀分布到复杂的马尔可夫链采样,形成完整技术体系。进阶研究可关注:

- 噪声调度策略:参考扩散模型的时变噪声强度

- 自适应噪声:根据判别器置信度动态调整噪声参数

- 多模态融合:结合均匀分布与高斯分布的混合策略

完整代码库:generative-models

通过科学配置噪声参数,可使模型在稳定性和多样性间取得平衡。建议从denoising_vae和infogan模块开始实践,这两个实现包含了最丰富的噪声控制技巧。

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

项目地址: https://gitcode.com/gh_mirrors/gen/generative-models

项目地址: https://gitcode.com/gh_mirrors/gen/generative-models

所有评论(0)