vid2vid技术演讲准备:从内容设计到现场演示

### 核心价值呈现vid2vid是基于PyTorch的高分辨率视频转视频翻译技术,支持2048x1024等超清分辨率的 photorealistic 转换。技术核心在于将语义标签图、边缘图或姿态图转化为逼真视频,已在街景生成、人脸动画和人体姿态迁移等场景验证效果。### 技术原理简化表达采用"粗到精"的生成策略,通过多尺度空间网络([models/vid2vid_model_G.py](...

vid2vid技术演讲准备:从内容设计到现场演示

演讲内容架构设计

核心价值呈现

vid2vid是基于PyTorch的高分辨率视频转视频翻译技术,支持2048x1024等超清分辨率的 photorealistic 转换。技术核心在于将语义标签图、边缘图或姿态图转化为逼真视频,已在街景生成、人脸动画和人体姿态迁移等场景验证效果。

技术原理简化表达

采用"粗到精"的生成策略,通过多尺度空间网络(models/vid2vid_model_G.py)和时序判别器(models/vid2vid_model_D.py)实现视频连贯性。关键创新点包括:

- 流场 warping 技术提升帧间一致性

- 前景-背景分离模型优化细节生成

- 多GPU并行训练架构支持超高清分辨率

视觉素材准备

核心效果展示

以下为三类典型应用场景的转换效果,可用于演讲核心章节的视觉辅助:

街景生成

从语义标签图生成逼真街景,支持风格变化与标签编辑:

人脸动画

从边缘图生成自然面部表情变化,支持多人物同时转换:

技术流程图解

使用mermaid绘制简化版技术架构图,插入"技术原理"章节:

演示环境配置

硬件需求

- 推荐配置:8×GPU(≥24GB显存),用于完整演示2048×1024分辨率转换

- 最低配置:单GPU(≥12GB显存),可演示1024×512分辨率scripts/street/train_g1_1024.sh

软件部署步骤

- 克隆仓库并安装依赖:

git clone https://gitcode.com/gh_mirrors/vi/vid2vid

cd vid2vid

pip install dominate requests dlib

- 下载预训练模型与测试数据:

python scripts/download_datasets.py

python scripts/download_flownet2.py

python scripts/street/download_models.py # 街景模型

- 启动测试演示:

# 2048×1024分辨率测试

bash ./scripts/street/test_2048.sh

# 输出路径:./results/label2city_2048/test_latest/

关键代码片段讲解

测试参数配置

scripts/street/test_2048.sh中的核心参数说明:

python test.py \

--name label2city_2048 \ # 模型名称

--label_nc 35 \ # 标签类别数

--loadSize 2048 \ # 输入分辨率

--n_scales_spatial 3 \ # 空间尺度数

--use_instance \ # 启用实例分割

--fg \ # 前景分离

--use_single_G # 单生成器模式

训练选项解析

options/train_options.py中影响演示效果的关键参数:

n_frames_total: 控制训练序列长度,建议演讲中设为12以平衡速度与效果max_frames_per_gpu: 单GPU帧数量,显存不足时可降低至3lambda_T: 时序一致性损失权重,建议保持默认值10.0

现场演示应急预案

环境故障处理

- GPU内存不足:立即切换至单GPU脚本scripts/street/test_g1_1024.sh

- 推理速度过慢:使用

--n_scales_spatial 2降低尺度层级 - 结果异常:检查options/test_options.py中的

--use_single_G参数是否启用

演示流程控制

建议采用"预生成+实时演示"混合模式:

- 预生成3组不同场景的完整视频,存储于

results/目录 - 实时演示限制在1024×512分辨率,推理单段10帧序列

- 准备imgs/framePredict.gif作为备用演示素材

演讲收尾设计

技术展望

- 多模态输入支持(文本+图像引导)

- 实时转换优化(当前2048×1024分辨率约0.5帧/秒)

- 移动端部署可能性探讨

资源分享

提供完整演示复现指南:

- 项目文档:README.md

- 训练脚本集:scripts/

- 数据集下载:scripts/download_datasets.py

互动环节预告:现场接受分辨率优化、训练调参等技术问题咨询,可结合具体应用场景提供参数配置建议。

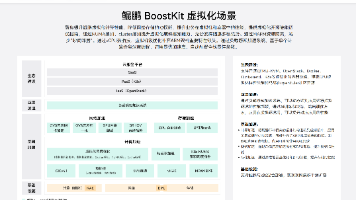

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

项目地址: https://gitcode.com/gh_mirrors/vi/vid2vid

项目地址: https://gitcode.com/gh_mirrors/vi/vid2vid

所有评论(0)