【昇腾CANN训练营·进阶篇】乾坤大挪移:达芬奇架构下的 Transpose 高效实现心法

摘要:本文深入探讨昇腾NPU上数据重排性能优化策略。针对Transpose/Permute操作导致的计算流等待问题,提出三种硬件级优化方案:1)利用MTE引擎的Stride搬运实现内存搬运时的数据重排;2)使用Vector单元的Gather指令处理UB内部细粒度重排;3)借助Cube单元的格式转换电路完成大规模矩阵转置。特别指出,通过MatMul伪计算可充分利用Cube单元的高吞吐特性。文章强调在

训练营简介 2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252#cann-camp-2502-intro

摘要:在 MSProfiler 的 Timeline 中,你是否经常看到计算流(Vector Core)即使占用率不高,也依然在长时间等待?这往往是由于 Transpose 或 Permute 导致的数据搬运瓶颈。本文将深入昇腾 MTE (Memory Transfer Engine) 硬件机制,揭示如何利用 Stride 搬运 和 Cube 格式转换 这一对“卧龙凤雏”,将乱序重排的开销降至最低。

前言:当 Vector 遇到“散装”数据

在通用 CPU 编程中,矩阵转置可能只是一个 for 循环交换下标的问题。但在 Ascend AI Core 上,这却是一个严重的性能杀手。

达芬奇架构的 Vector 单元是 SIMD(单指令多数据)架构,它最喜欢吃连续的内存块(Contiguous Blocks)。一旦遇到 Transpose(转置)或 Permute(维度置换),数据在物理内存上变得“支离破碎”。 如果不加处理直接交给 Vector 计算,算力利用率可能跌至 1/32 以下。

这篇不讲通用算法,只讲如何在昇腾 NPU 上利用硬件特性解决这个问题。

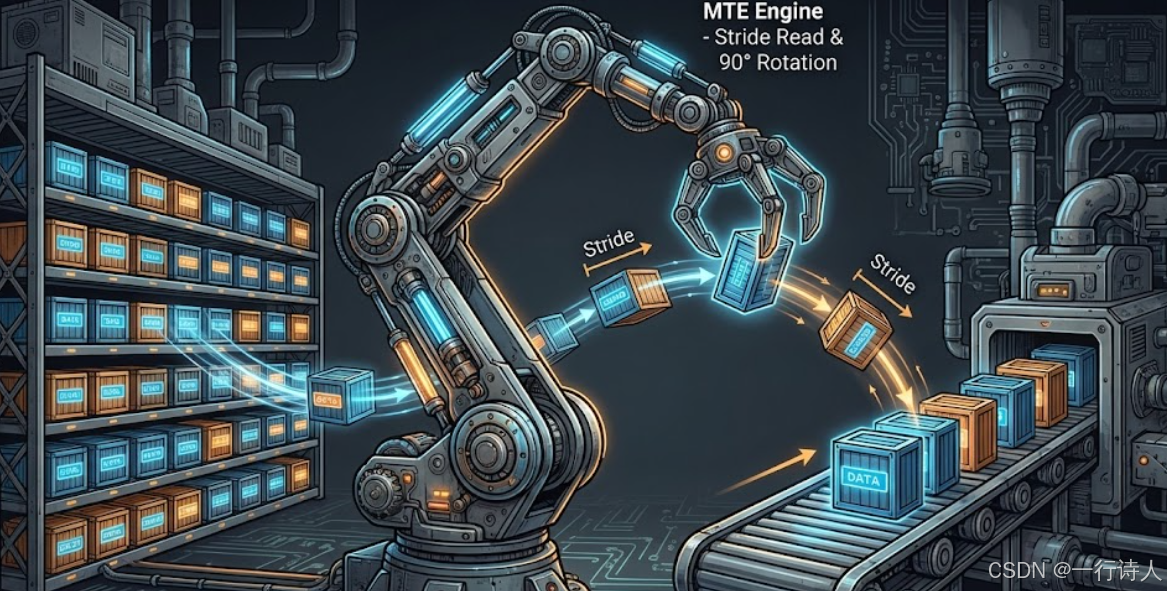

一、 核心图解:搬运即重排 (Load-time Reshape)

最廉价的转置,是发生在搬运路上的。 Ascend C 的 DataCopy 接口底层对应的是 MTE2/MTE3 搬运指令。这些硬件单元具备强大的**Stride(步长)**处理能力。我们可以在把数据从 Global Memory (GM) 搬到 Unified Buffer (UB) 的过程中,顺手把形状给变了。

二、 核心武器:DataCopy 的 Stride 魔法

很多开发者只把 DataCopy 当作 memcpy 用,忽略了它的参数 DataCopyParams 其实是 MTE 硬件的“遥控器”。

// DataCopyParams { blockCount, blockLen, srcStride, dstStride }

DataCopy(dstLocal, srcGlobal, params);

2.1 场景:多维 Permute (NHWC -> NCHW)

假设我们要搬运一张图,原格式是 H=32, W=32, C=16。现在想把 C 维度换到前面。 如果用 CPU 思维,你可能会写三层循环。 但在 Ascend C 中,我们可以寻找最大连续块。

-

策略:一次搬运一个 C (16个元素),然后跳过 W 个像素。

-

硬件行为:MTE 会像“跳房子”一样,精准地把分散在 GM 上的 C 维度数据,抓取并紧凑地塞进 UB。

这完全不消耗 Vector 计算单元的算力!

三、 实战:Vector Gather 指令 (UB 内部重排)

如果数据已经到了 UB 里面,需要进行细粒度的打散(比如 Shuffle),MTE 就帮不上忙了。这时候需要呼叫 Vector 单元的 Gather 指令。

3.1 离散索引查表

Gather 允许我们提供一个索引向量(Indices),让 Vector 单元按照索引去“捞”数据。

// 场景:在 UB 内部将 16x16 的小块进行转置

// 1. 准备索引:indices = [0, 16, 32... 1, 17, 33...]

// 这通常可以在 Host 侧预计算好,作为 Tiling 参数传进来

LocalTensor<uint32_t> indices = ...;

// 2. 执行 Gather

// dst = src[indices]

// mask=256 表示操作 256 个元素

Gather(dstLocal, srcLocal, indices, 256);

注意:Gather 属于非连续访存指令,性能低于连续计算指令,非必要不使用。

四、 进阶黑科技:借用 Cube 单元做转置

这是昇腾架构独有的“隐藏大招”。 众所周知,昇腾的 Cube 单元(矩阵加速器)在计算 MatMul 时,要求数据必须是 Fractal Z(分形)等特殊私有格式。 因此,Cube 单元内部配备了强大的 Format Conversion (格式转换电路)。

4.1 移花接木:MatMul Trick

如果你有一个巨大的矩阵需要转置,用 Vector 搬运太慢。你可以构造一个恒等矩阵 $I$ (Identity Matrix),然后计算: $$ B = A \times I $$ 但在配置 MatMul 时,开启 Transpose A 属性。

发生了什么?

-

L1 -> Cube:硬件会自动将 $A$ 从 ND 格式转换为 Fractal 格式(过程中完成了分块重排)。

-

Cube 计算:利用 Cube 内部的高带宽完成“伪计算”。

-

Cube -> GM:结果写回时,再次经过格式转换电路。

这一过程充分利用了 Cube 单元恐怖的吞吐量(910B 上可达几百 TFLOPS),比纯 Vector 搬运快得多。这就是为什么在昇腾上,有时候计算比搬运更快。

五、 总结

在昇腾 CANN 上优化 Transpose,本质上是一场对硬件单元的调度游戏。

-

MTE 优先:能用

DataCopy的 stride 解决,绝不进 Vector。 -

Vector 兜底:小规模乱序用

Gather。 -

Cube 降维打击:超大规模矩阵转置,考虑用 MatMul 的硬件电路“借力打力”。

记住:最好的重排,是“没有重排”。在设计算子之初,尽量通过 Layout Propagation(排布推导)让数据天然处于正确的格式,才是最高级的优化。

本文基于昇腾 CANN 8.0 及 Ascend C 编程模型撰写。

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献58条内容

已为社区贡献58条内容

所有评论(0)