【2023 · CANN训练营第一季】MindSpore模型快速调优攻略 第四章——MindSpore调试调优实践

BERT(Bidirectional Encoder Representations from Transformers)是由Google提出的具有里程碑意义的自然语言理解模型,BERT能够充分利用海量的无标注数据对模型进行预训练,另模型学习到大量的语言知识。基于预训练先验知识的情况下,通过在下游任务上进行微调,即可达到较好的效果。执行该命令后,转换后的文件保存在当前目录下的output目录中(转

模型一键迁移

情感分析:对带有情感色彩的主观性文本进行分析、处理、归纳和推理的过程。

BERT(Bidirectional Encoder Representations from Transformers)是由Google提出的具有里程碑意义的自然语言理解模型,BERT能够充分利用海量的无标注数据对模型进行预训练,另模型学习到大量的语言知识。基于预训练先验知识的情况下,通过在下游任务上进行微调,即可达到较好的效果。

模型下载路径:mindconverter --model_file bert_zh.onnx \ --shape 1,512 1,512 1,512 \ --input_nodes input_ids attention_mask token_type_ids \ --output_nodes output_0 output_1

执行该命令后,转换后的文件保存在当前目录下的output目录中(转换时间约3~5分钟)。

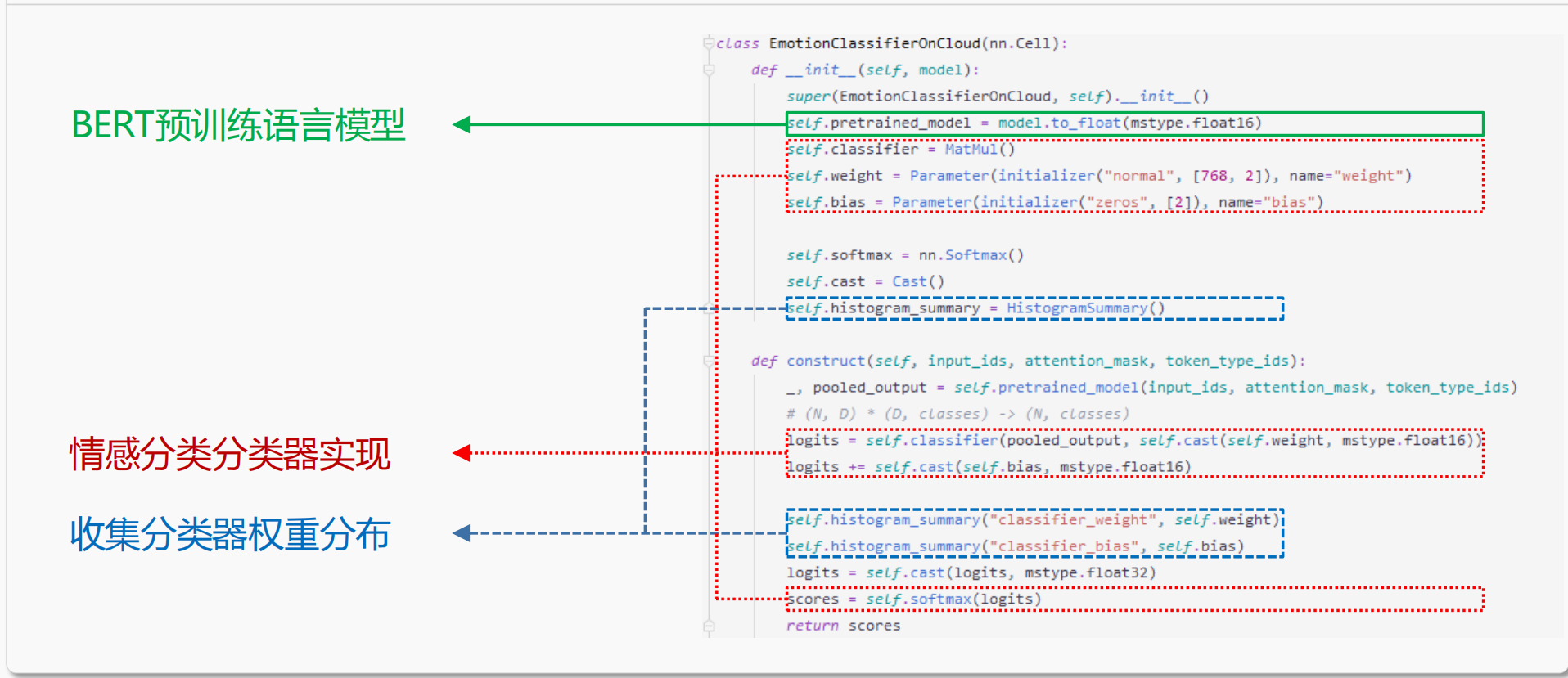

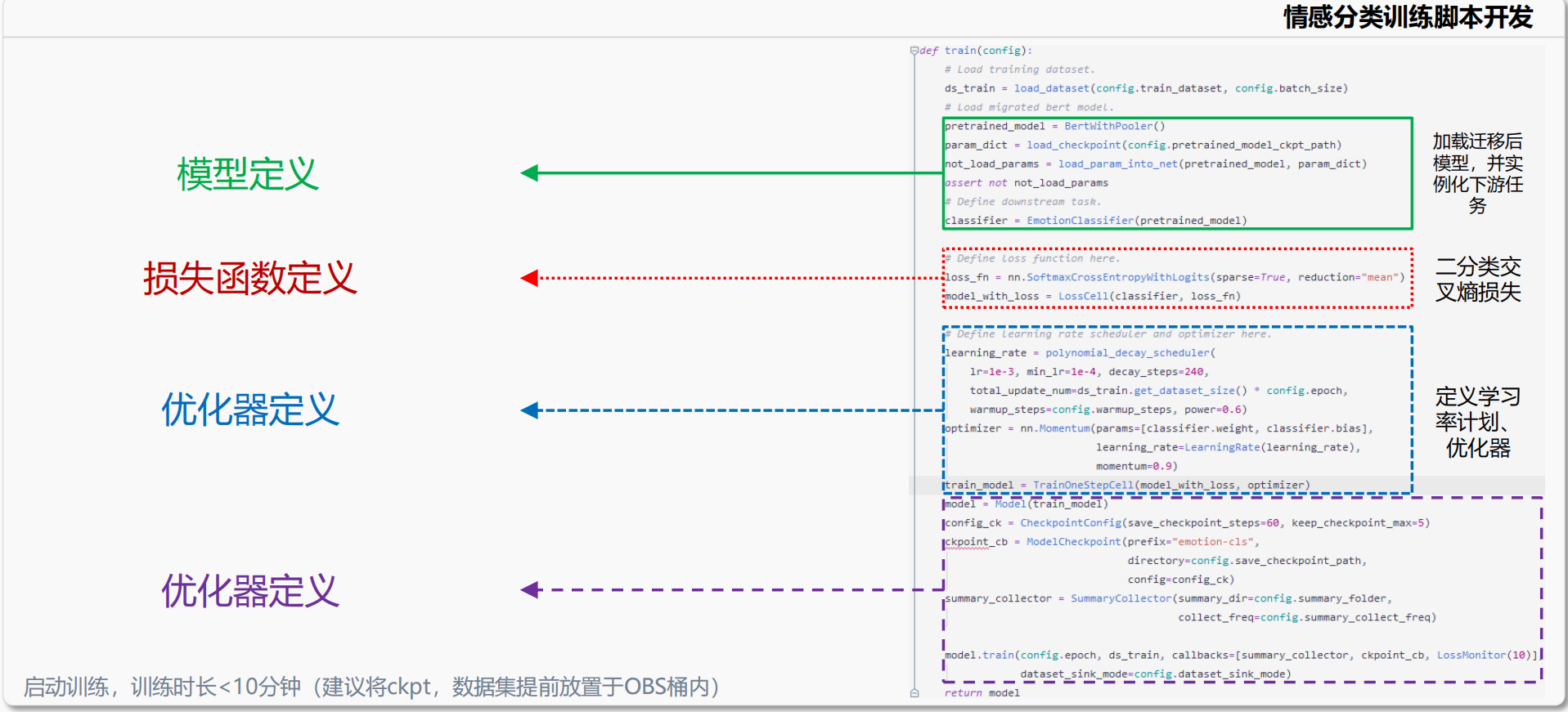

动静统一开发模式

训练过程可视化

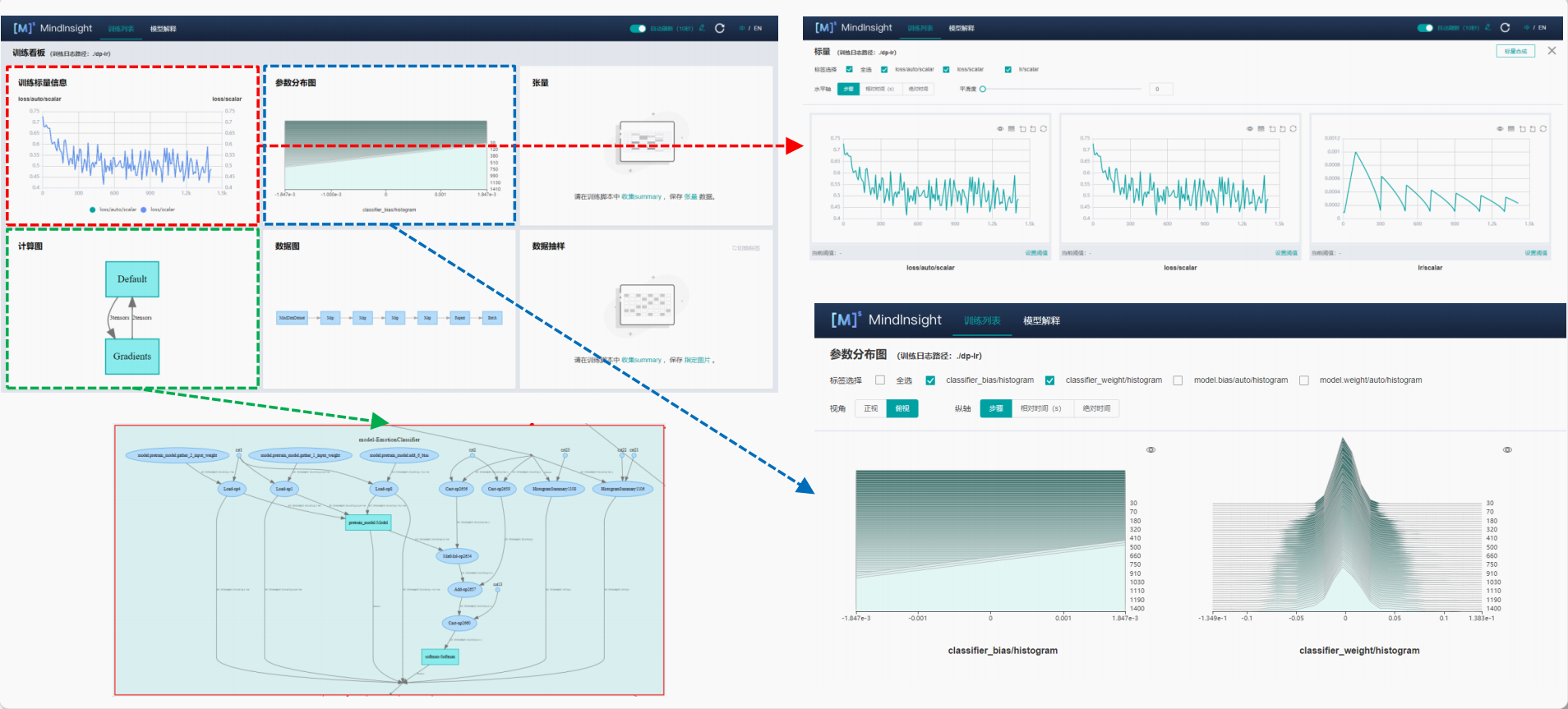

使用MindInsight观测训练过程

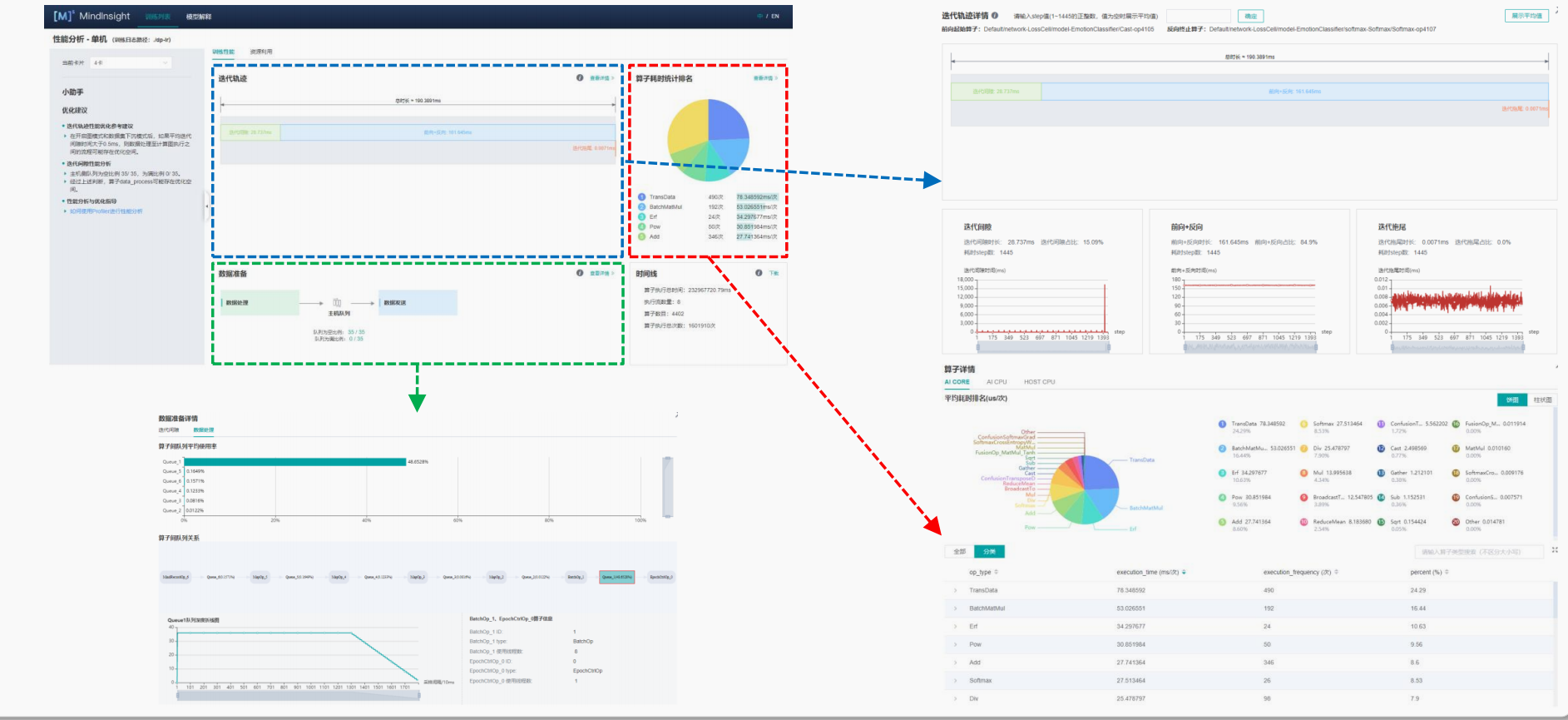

使用MindInsight观测性能数据

学习推荐

• MindSpore架构:MindSpore架构

• MindInsight架构:MindInsight架构

• MindConverter使用指南:MindConverter使用指南

• 调试器使用指南:调试器使用指南

• 性能调试器使用指南:性能调试器使用指南

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)