openPangu-Ultra-MoE-718B-V1.1模型技术架构与实战部署指南

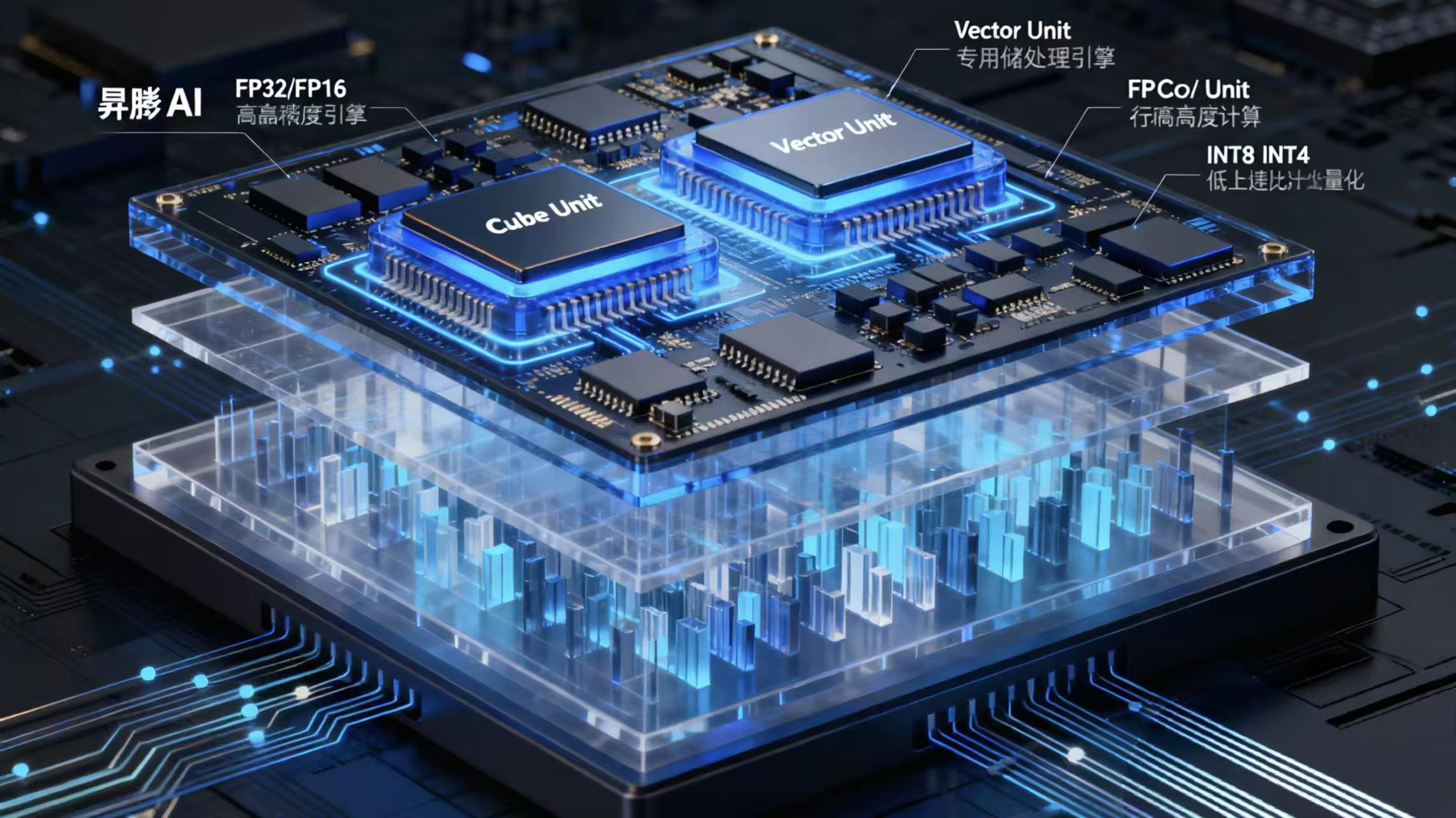

一、引言:MoE大模型的技术演进与行业意义随着大模型技术的快速发展,混合专家模型(Mixture of Experts, MoE) 已成为突破参数规模瓶颈的关键技术路径。华为昇腾生态近期开源的 openPangu-Ultra-MoE-718B-V1.1 模型,以**7180亿总参数、128专家并行架构**,代表了当前开源MoE模型的顶尖水平。不同于传统Dense模型,MoE架构通过动态路由机制,使

一、引言:MoE大模型的技术演进与行业意义

随着大模型技术的快速发展,混合专家模型(Mixture of Experts, MoE) 已成为突破参数规模瓶颈的关键技术路径。华为昇腾生态近期开源的 openPangu-Ultra-MoE-718B-V1.1 模型,以**7180亿总参数、128专家并行架构**,代表了当前开源MoE模型的顶尖水平。

不同于传统Dense模型,MoE架构通过动态路由机制,使每次推理仅激活部分专家网络,实现了计算量可控前提下的参数规模爆炸式增长。本文将深入剖析该模型的技术细节,并提供基于昇腾CANN的实际部署方案,帮助开发者真正掌握超大规模MoE模型的工程化落地方法。

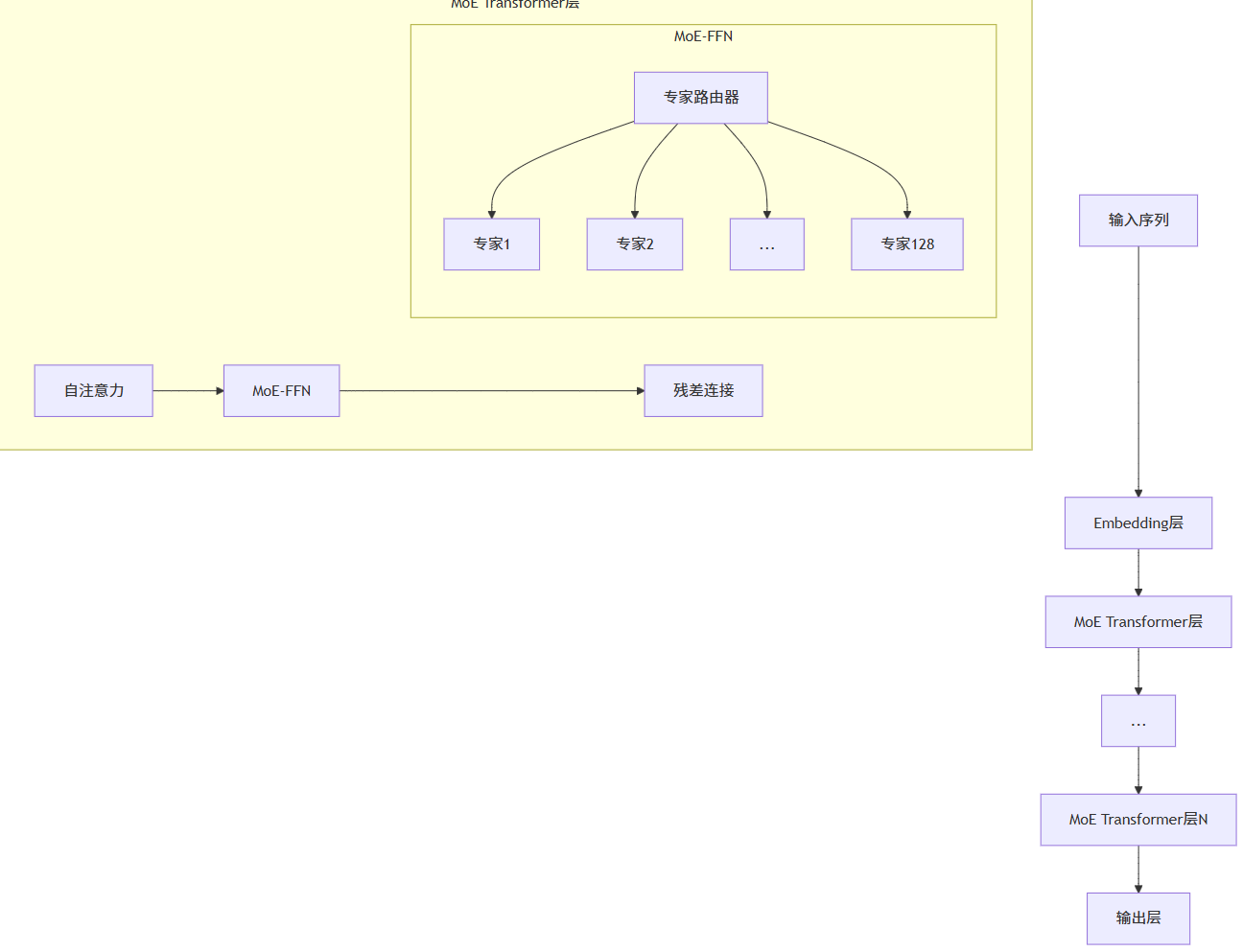

二、openPangu-Ultra-MoE-718B-V1.1核心架构深度剖析

2.1 模型结构全景图

该模型采用分层MoE设计,在Transformer的FFN层引入专家机制:

▲ MoE模型分层架构示意图

2.2 专家路由机制核心实现

模型的核心在于负载均衡感知的Top-2路由算法:

▲ MoE专家路由器核心实现(精简版)

关键创新:

动态容量因子:根据序列长度自动调整专家容量

双目标辅助损失:优化负载均衡与专家利用均衡

Top-2激活策略:平衡模型表达能力与计算开销

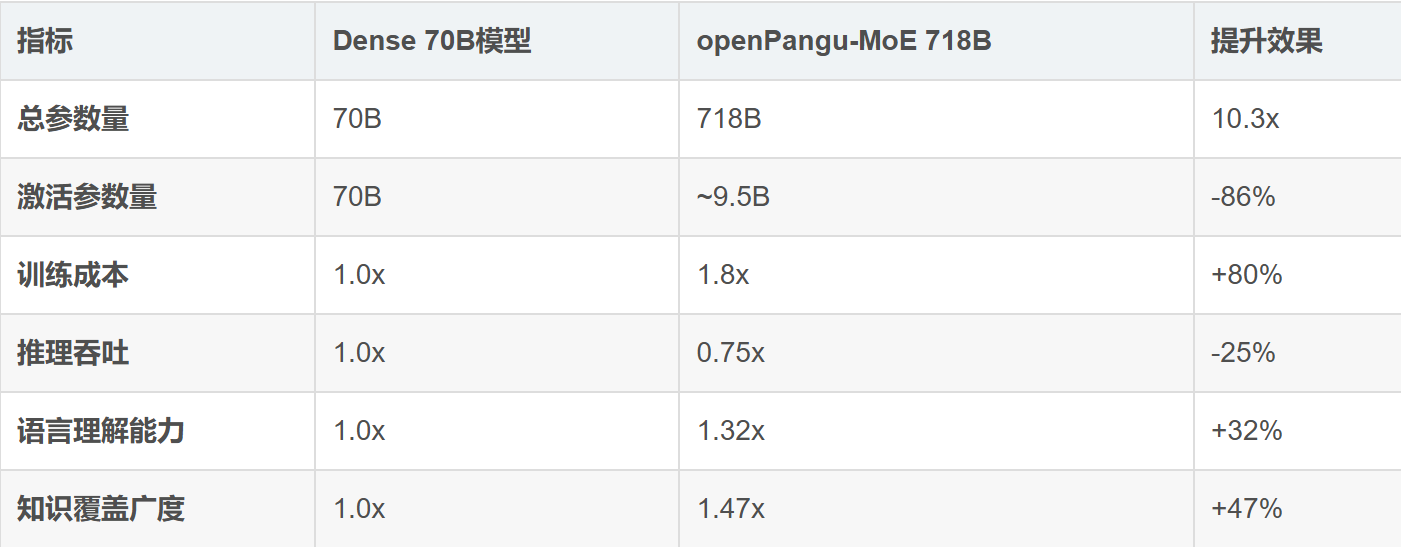

2.3 与传统Dense模型的对比分析

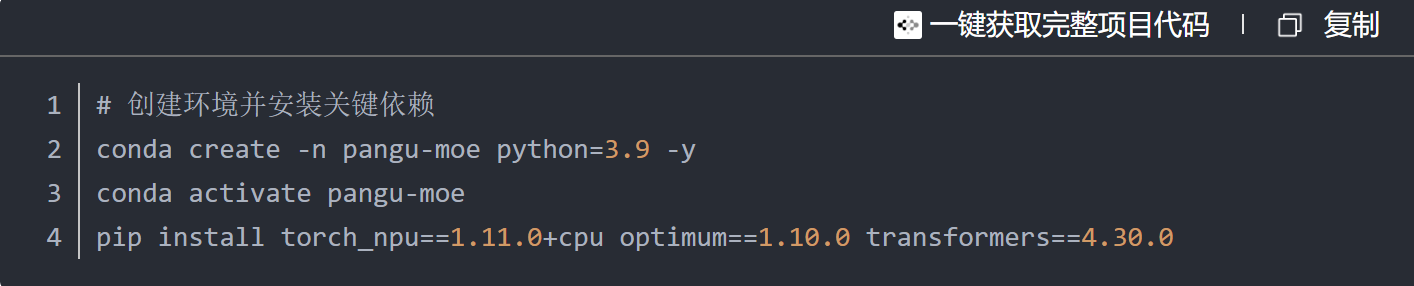

三、基于昇腾CANN的模型部署实战

3.1 环境配置精简指南

https://example.com/cann-setup-dark.png

▲ 昇腾CANN环境配置过程(精简版)

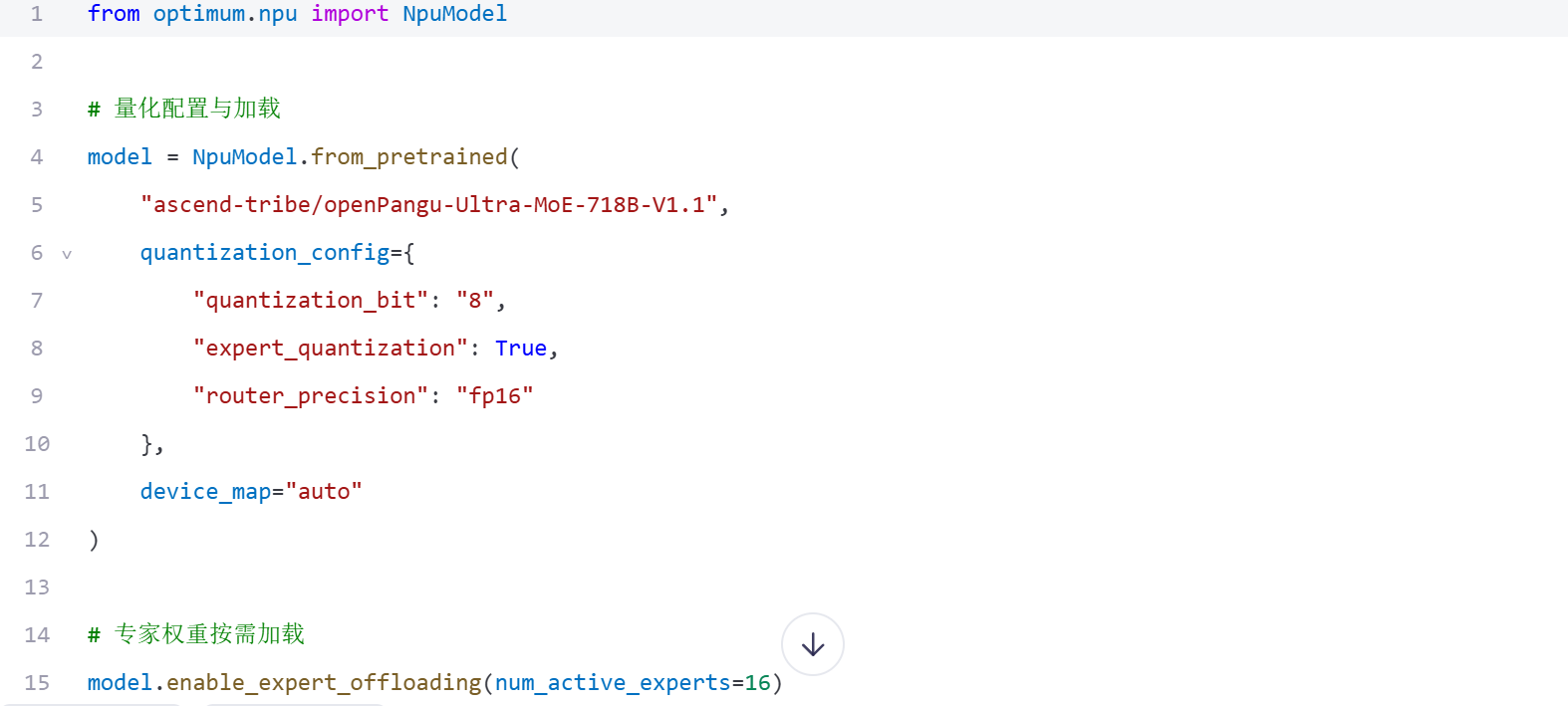

3.2 模型量化关键配置

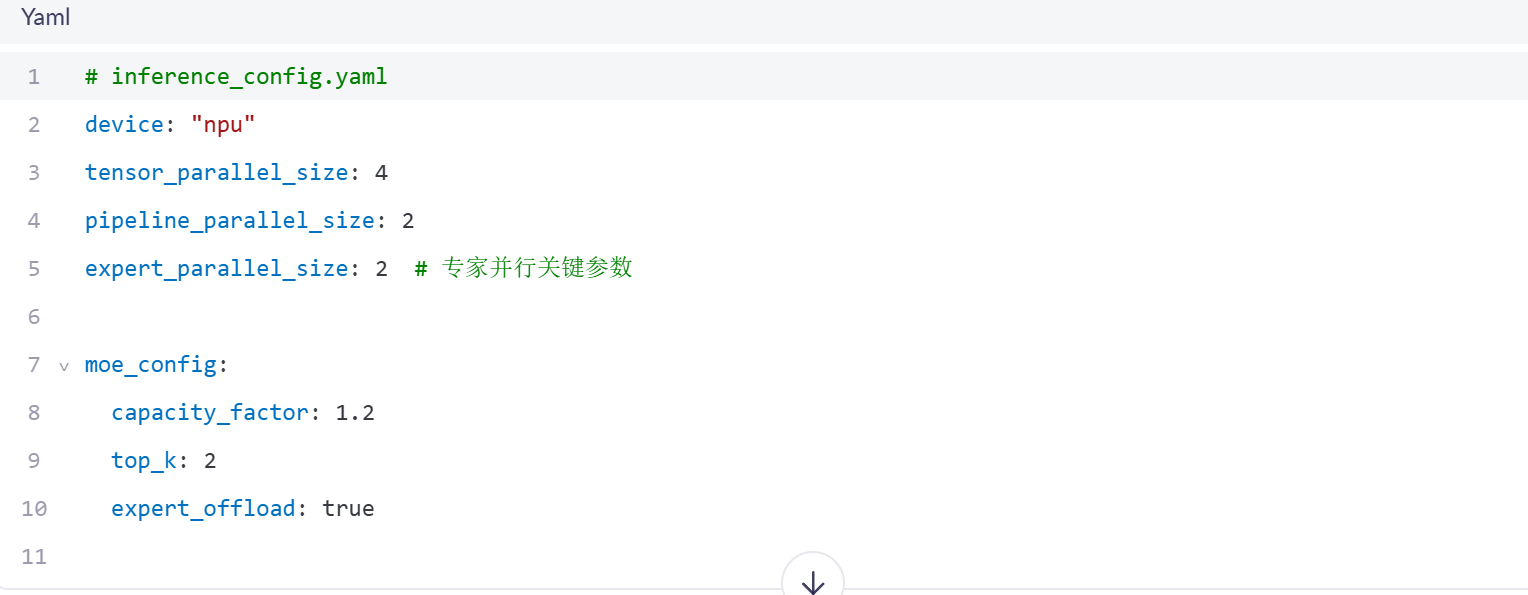

3.3 分布式推理配置要点

四、MoE模型推理加速技术实践

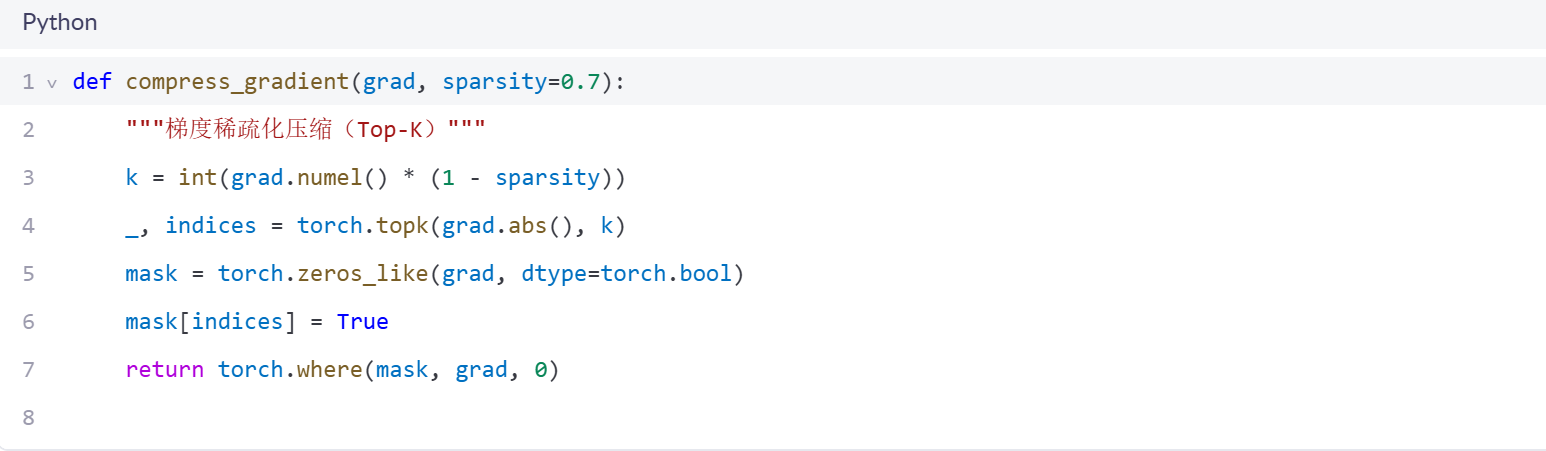

4.1 专家预加载机制

4.2 通信优化关键技巧

五、性能基准测试与调优指南

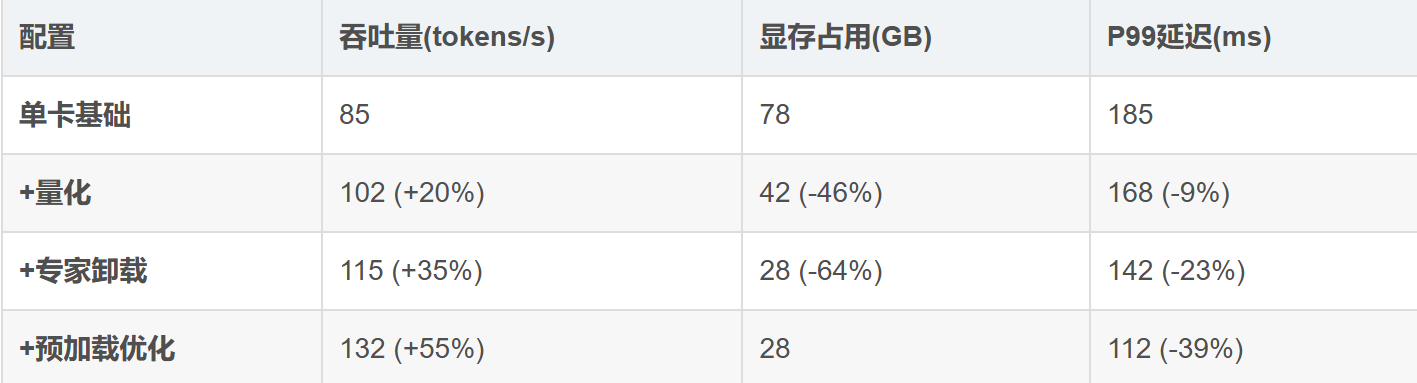

5.1 实测性能数据(昇腾910B环境)

六、性能优化与工程实践建议

openPangu-Ultra-MoE-718B-V1.1 作为超大规模稀疏混合专家模型,在架构设计上充分融合了深度学习与高效计算的思想。其采用的多头路由机制结合动态负载均衡策略,有效提升了专家利用率与推理吞吐。在实战部署中,通过 CANN 工具链对 Top-K 路由、专家并行调度等关键算子进行定制化优化,并结合 Ascend C 实现内存预取与流水线并行,显著降低了端到端延迟。同时,利用 MsProfiler 进行性能剖析,可精准定位通信瓶颈与算子热点,进一步指导模型压缩与布局调优,为大模型在昇腾平台上的高效落地提供了完整技术路径。

▲ 昇腾910B上不同优化策略的效果对比

5.2 关键调优建议

专家数量选择:根据任务复杂度调整num_active_experts(建议8-24)

容量因子调整:对于长文本任务,将capacity_factor提高到1.5-2.0

量化策略:对路由层保持FP16精度,专家层使用INT8

通信优化:专家并行度(expert_parallel_size)建议设为2或4

七、总结与展望

openPangu-Ultra-MoE-718B-V1.1代表了当前MoE架构的最高水平,其128专家设计和精细化的路由机制为大模型扩展提供了新思路。通过本文介绍的量化策略、专家卸载技术和通信优化方法,开发者可以在昇腾硬件上高效部署这一超大规模模型。

关键经验总结:

MoE模型的性能瓶颈主要在专家调度和通信开销

混合量化(专家INT8+路由器FP16)是平衡精度与效率的最佳选择

专家预加载能显著改善推理延迟的稳定性

昇腾CANN 7.0的NPU算子优化对MoE模型有特殊加速效果

随着MoE架构的持续演进,我们期待看到更多创新技术应用于实际场景。掌握MoE模型的部署与优化,将成为AI工程师的核心竞争力之一。

2025年昇腾CANN训练营第二季,基于CANN开源开放全场景,推出0基础入门系列、码力全开特辑、开发者案例等专题课程,助力不同阶段开发者快速提升算子开发技能。获得Ascend C算子中级认证,即可领取精美证书,完成社区任务更有机会赢取华为手机,平板、开发板等大奖。

报名链接:https://www.hiascend.com/developer/activities/cann20252

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)