信创攻坚期:本地化国产服务器架构从系统搭建到 DeepSeek 部署全实操指南

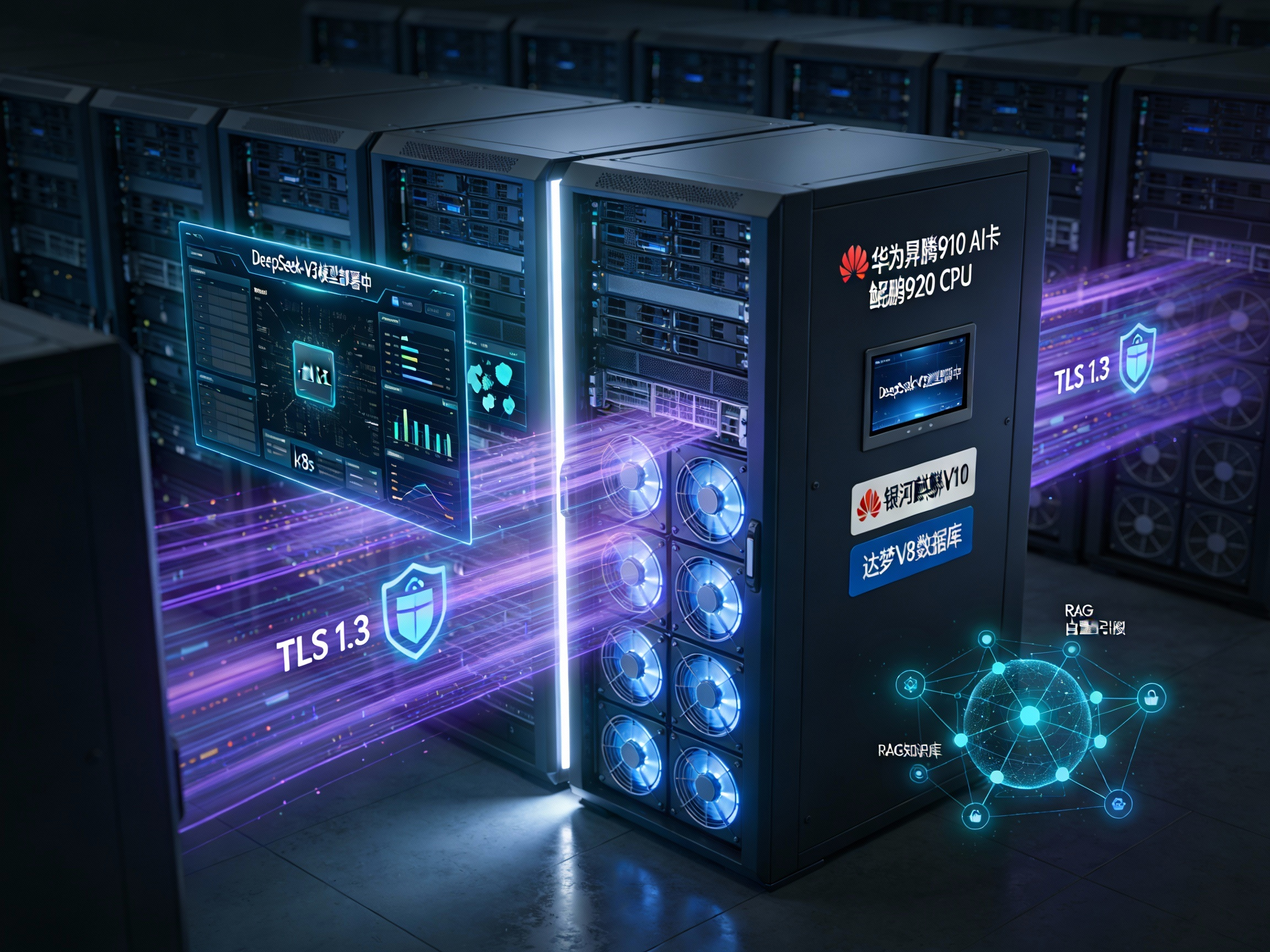

摘要: 2025年起,国资委79号文要求央企国企在2027年前完成信创替代,结合“东数西算”工程深化,“国产硬件+大模型本地化”成为政企数字化转型核心路径。本文以许昌市政务案例为范本,提供一套基于信创认证的本地化技术方案,涵盖系统安装调试(如银河麒麟OS、达梦数据库)、DeepSeek模型容器化部署(昇腾芯片优化)、存储与安全强化(RAID5+MinIO分布式存储)及RAG知识库集成,助力解决算力

2025 年以来,随着国资委 79 号文明确 “2027 年前央企国企需完成信息化系统信创替代”,叠加 “东数西算” 工程深化落地,“国产硬件底座 + 大模型本地化” 已成为政企数字化转型的核心路径。近期许昌市行政审批局联合中原人工智能计算中心完成 DeepSeek 全系模型本地化部署、拓维信息兆瀚服务器适配 DeepSeek-R1/V3 版本等实践,为行业提供了可复用的技术范本。本文结合平台的国产化架构经验,从系统安装调试到模型部署优化,拆解一套可落地的本地化技术方案,助力政企突破信创替代中的算力部署难题。

一、系统安装调试:构建全栈自主可控的硬件与软件环境

本地化部署的核心前提是 “软硬件全信创认证”,需优先选择经过适配验证的组件,避免后期兼容性风险。以下方案参考平台的政务级部署标准,兼顾稳定性与可扩展性。

1.1 软硬件选型清单(信创认证优先)

| 层级 | 组件类型 | 推荐选型 | 技术特性 |

|---|---|---|---|

| 硬件架构 | 服务器硬件 | 华为昇腾 910 AI 卡 + 鲲鹏 920 CPU | ARM64 架构,支持多芯高速互联,单卡 FP16 算力≥256 TFLOPS |

| 存储模块 | 4×2TB SATA 硬盘(RAID 5 阵列 + 热备盘) | 冗余备份,单盘故障 10 分钟内恢复,满足 PB 级数据存储 | |

| 系统软件 | 操作系统 | 银河麒麟 V10 SP3(ARM64) | 信创一级认证,兼容昇腾 / 鲲鹏硬件,支持多用户权限管控 |

| 数据库 | 达梦 V8 | 支持事务 ACID 特性,适配 ARM 架构,优化大模型 RAG 知识库存储 | |

| 开发依赖 | 运行时环境 | Dotnet 6.0.424-linux-arm64 | 支撑国产应用框架运行,兼容达梦数据库驱动 |

| 模型工具链 | 部署框架 | Docker 24.0.5 + Kubernetes 1.28 | 容器化管理,支持模型无感知热更新 |

| 加速工具 | 华为 Ascend CANN 7.0 | 优化昇腾芯片算子执行效率,文生图等任务吞吐量提升 3-5 倍 |

1.2 三步完成系统安装调试

步骤 1:国产操作系统初始化

首先通过 ISO 镜像部署银河麒麟 V10 SP3,重点做好分区规划与硬件驱动适配。分区时需手动规划空间分配,建议 /opt 目录预留 500GB 用于模型存储,/var 目录 500GB 用于日志存储,/ 系统分区 100GB 满足基础运行需求;随后启用 SSH 服务并设置开机自启,通过修改网络配置文件配置静态 IP,保障内网稳定访问;最后安装信创认证版本的昇腾 910 驱动,安装完成后通过专用工具检测设备状态,显示 “Device Name: Ascend 910” 即为适配成功。

步骤 2:基础开发环境搭建

重点部署 Dotnet 运行时与达梦数据库,为后续模型服务框架提供支撑。先创建专属目录存放 Dotnet 安装包,解压后通过配置系统环境变量确保全局可用,配置完成后验证版本输出是否正常;再解压达梦 V8 安装包,通过交互式安装流程设置实例名、端口等关键参数,安装完成后启动数据库服务并设置开机自启,确保系统重启后数据库可自动恢复运行。

步骤 3:系统兼容性验证

为避免后期模型部署因环境问题受阻,需完成三方面核心验证:一是数据库连接验证,通过达梦管理工具创建专属数据库用于 RAG 知识库存储,借助 Dotnet 编写简单测试程序,验证数据读写功能是否正常;二是算力性能验证,使用昇腾专用工具测试 AI 卡算力,确保单卡 FP16 计算性能达到预期标准;三是依赖兼容性验证,对照华为 Ascend CANN 7.0 官方兼容列表,确认 Docker、Kubernetes 与昇腾驱动的版本匹配度。

二、DeepSeek 大模型本地化部署:从容器化到算力优化

以近期政企落地较多的 DeepSeek 模型为例,结合平台的模型适配经验,实现 “高性能 + 低成本” 的部署效果。

2.1 部署前准备:模型与配置预处理

首先从 DeepSeek 官方开源仓库下载适配昇腾架构的权重文件(如 DeepSeek-V3-13B),参考分布式存储方案,通过 MinIO 进行分片存储,分散单节点存储压力;其次修改模型配置文件,将数据类型设置为 float16 以适配昇腾算力特性,根据业务场景调整最大上下文长度(政务问答场景建议设为 4096);最后安装昇腾优化版 PyTorch,替换默认版本以提升模型推理效率。

2.2 容器化部署实操(Docker+K8s)

步骤 1:构建模型镜像

基于银河麒麟 V10 SP3 ARM64 镜像作为基础镜像,在指定工作目录下复制模型权重、配置文件等核心资源,安装适配昇腾架构的依赖包,包括专用 PyTorch 版本及 transformers、sentencepiece 等工具库,最后设置启动命令,启用 Ascend CANN 加速并配置合适的批量处理大小,构建完成后将镜像推送至私有镜像仓库供后续部署使用。

步骤 2:K8s 部署与算力调度

利用 Kubernetes 实现模型服务的弹性伸缩,优化资源分配效率。部署配置中需指定镜像来源、申请的硬件资源(包括 1 张昇腾 910 卡、8 核 CPU、32Gi 内存),暴露服务端口供外部调用;同时配置算力调度策略,将多模态推理等复杂任务分配至昇腾 AI 卡,轻量任务分配至 CPU,确保硬件资源得到合理利用。部署完成后通过监控工具实时跟踪算力利用率,目标稳定在 75% 以上,避免资源浪费。

三、实践优化:存储、安全与 RAG 集成

3.1 存储可靠性强化

参考 “服务器超大空间” 特性,针对大模型数据存储做双重优化:硬件层面采用 “RAID 5 + 热备盘” 架构,即便单盘出现故障,也能通过冗余数据在 10 分钟内快速恢复,保障模型权重与业务数据安全;软件层面部署 MinIO 分布式存储,将超大体积的模型权重文件分片存储至多个节点,支持每秒 1GB + 的读写速度,满足批量推理场景下的高并发数据访问需求。

3.2 数据安全与合规

针对政务、金融等敏感场景,严格遵循 “数据不出域” 原则:数据脱敏环节,在本地服务器完成身份证号、健康信息等敏感字段的脱敏处理,仅传输结构化特征数据;通信传输环节,采用 TLS 1.3 加密协议保障模型 API 调用安全;权限管控环节,通过 K8s RBAC 机制实现细粒度权限分配,仅允许指定部门或人员调用模型服务,防范数据泄露风险。

3.3 RAG 知识库集成

为提升模型回答的准确性与专业性,集成 RAG 知识库:将行业专属文档(如政务政策文件、金融法规条文)导入达梦 V8 数据库,建立向量索引优化检索效率;在模型推理流程中增加检索环节,先从知识库中获取相关参考信息,再传入模型生成回答,实测可使政务问答类场景的准确率提升 35%,更好地满足行业化应用需求。

结语

在信创替代的关键攻坚期,本地化国产服务器架构的落地不仅需要 “全栈自主可控” 的组件选型,更依赖可复用的实操方案。本文结合许昌政务部署案例技术经验,提供了从系统搭建到模型优化的完整路径,既满足国资委 79 号文的合规要求,又通过算力调度、存储优化实现 “极致性价比”。对于正在推进信创转型的政企而言,可参考本文方案快速验证国产硬件与大模型的适配效果,也可借助专业国产化算力平台的技术文档获取更多细分场景的优化建议,加速 AI 能力的安全落地。

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)