SmartX AI 基础设施新增昇腾 NPU 与 MindIE 支持能力:方案与评测

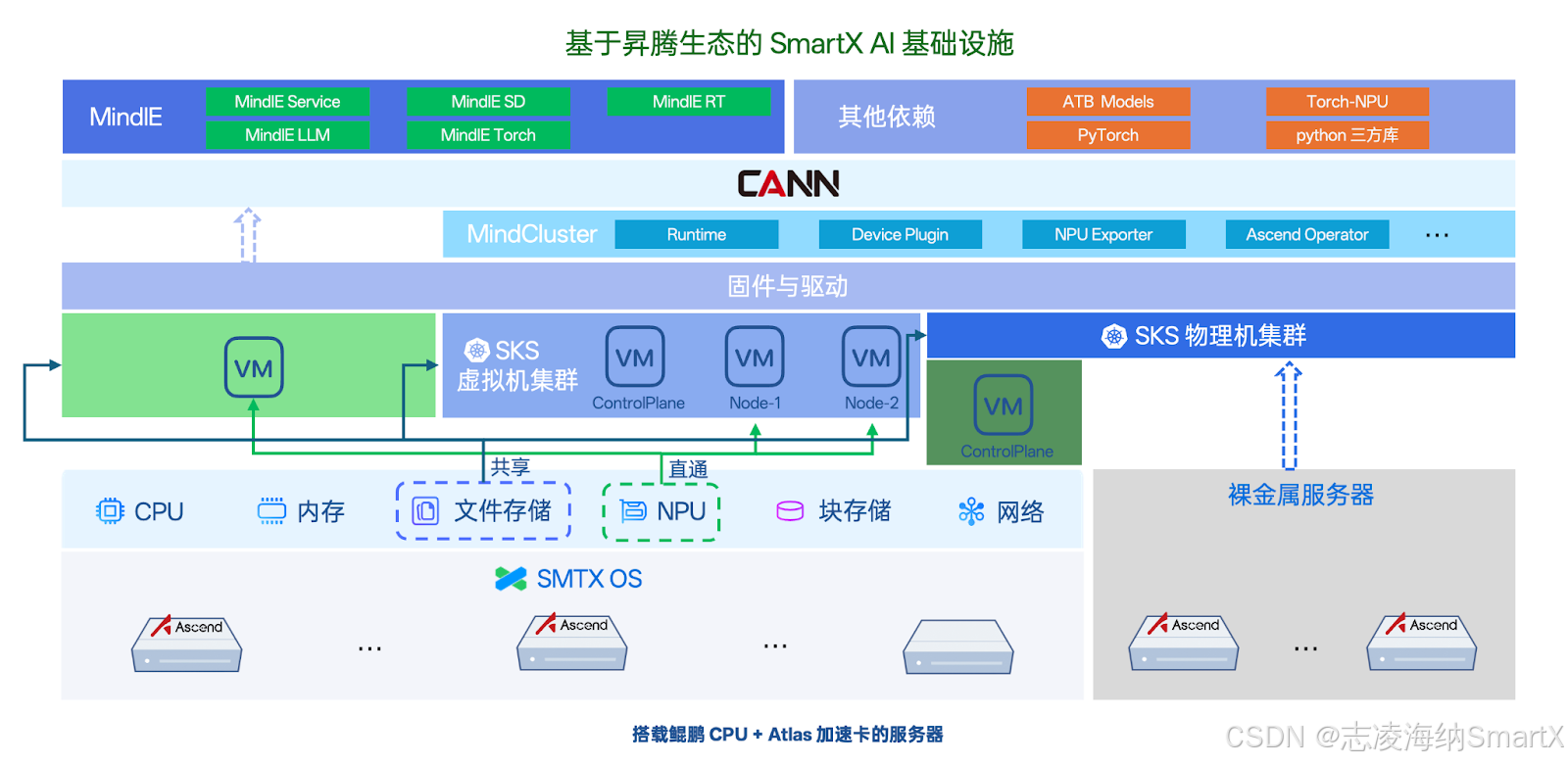

SmartX AI 基础设施新增对昇腾 NPU 与 MindIE 平台的支持能力,并基于超融合(虚拟机)与 SMTX Kubernetes 服务(SKS)环境开展性能评测。

近期,SmartX 推出了基于 AI 基础设施的 DeepSeek 解决方案,以一套技术栈同时为 AI 大模型和企业其他业务系统运行提供统一的基础设施资源,帮助企业快速推进大模型落地与验证进程。同时,考虑到金融、医疗等行业用户存在数据合规、国产化转型等方面的需求,需要在自主可控的环境下开展 AI 大模型测试与使用,SmartX AI 基础设施新增了对昇腾 NPU 与 MindIE 平台的支持能力,并基于超融合(虚拟机)与 SMTX Kubernetes 服务(SKS)环境开展了性能评测。

下载《构建企业 AI 基础设施:技术趋势、产品方案与测试验证》电子书,了解更多企业在 AI 大模型方面的部署验证与应用实践。

在 SmartX AI 基础设施中使用昇腾 NPU 与 MindIE 平台

目前,SmartX AI 基础设施已全面兼容昇腾生态,支持用户基于虚拟机、虚拟化 Kubernetes 和裸金属 Kubernetes 环境部署使用昇腾 NPU 与 MindIE 平台,帮助用户快速搭建全栈软硬件国产化的 AI 基础设施。

方案特点

- 高性能异构计算:兼容通用计算与 AI 专用负载,构建异构资源池。

- 灵活多样的部署方案:支持基于虚拟机、虚拟化 Kubernetes 和裸金属 Kubernetes 的部署方案,其中基于裸金属 Kubernetes 的部署方案可帮助用户避免虚拟化开销,发挥极致性能。

- 高效的资源利用:可通过 DRS 和虚拟机放置组功能实现虚拟机资源的动态分配与横向扩展,适应业务负载波动,提升资源利用率。

- 统一管理与运维简化:以统一的控制平面管理虚拟机、容器及物理机节点,简化环境运维。

- 全栈国产化支持:从 CPU 到昇腾 NPU,从 SmartX AI 基础设施到 AI 推理 MindIE 框架,实现软硬件全栈国产化适配,全面满足信创需求。

部署方案

基于虚拟机部署

用户可以在 SmartX 超融合虚拟机环境中,通过昇腾推理硬件直通功能和 MindIE 镜像方式,实现昇腾 NPU 与 MindIE 的快速部署,快速构建基于昇腾生态的 AI 推理框架,运行 DeepSeek 等大语言模型。简要步骤如下:

1.基础设施准备:

- 昇腾推理硬件直通:将 Atlas 300I Pro / Atlas 300I Duo 通过 SmartX 超融合直通给虚拟机使用。

- 安装昇腾驱动:在虚拟机中安装昇腾 Ascend 驱动包,提供硬件基础支持。

- 安装 Docker:在虚拟机中安装 Docker 运行环境,提供模型推理运行环境。

2.推理框架安装:

- 拉取 MindIE 镜像:昇腾镜像仓库提供 MindIE 基础镜像,用户可根据自己的硬件拉取对应的镜像文件,该镜像已具备模型运行所需的基础环境,包括:CANN、FrameworkPTAdapter、MindIE 与ATB-Models,可实现模型快速上手推理。

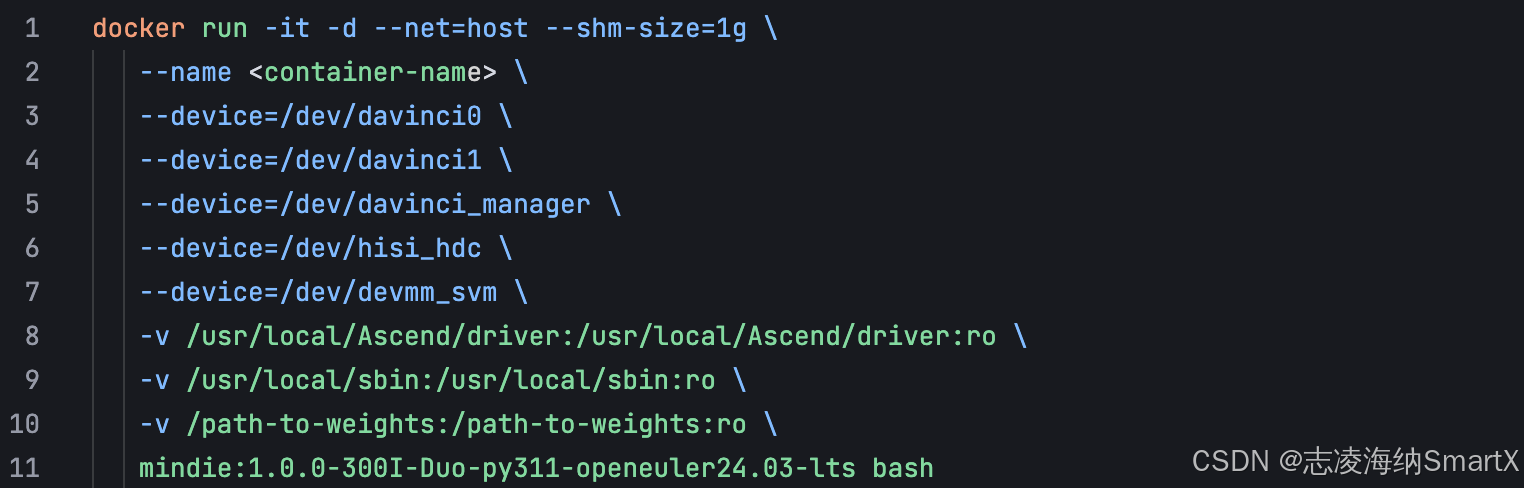

- 启动 MindIE 镜像:用户可根据自己的硬件和模型文件启动 MindIE 运行环境。

3.模型推理启动:

- 配置模型推理:用户需要根据需求配置模型的输入和输出,以最大输入 1024 tokens,最大输出 4096 tokens 为例:

- maxIterTimes = 4096

- maxInputTokenLen = 1024

- maxSeqLen = maxIterTimes + maxInputTokenLen = 5120

- 启动推理模型:进入容器中执行 MindIE 启动命令,用户即可运行 DeepSeek 等大语言模型。

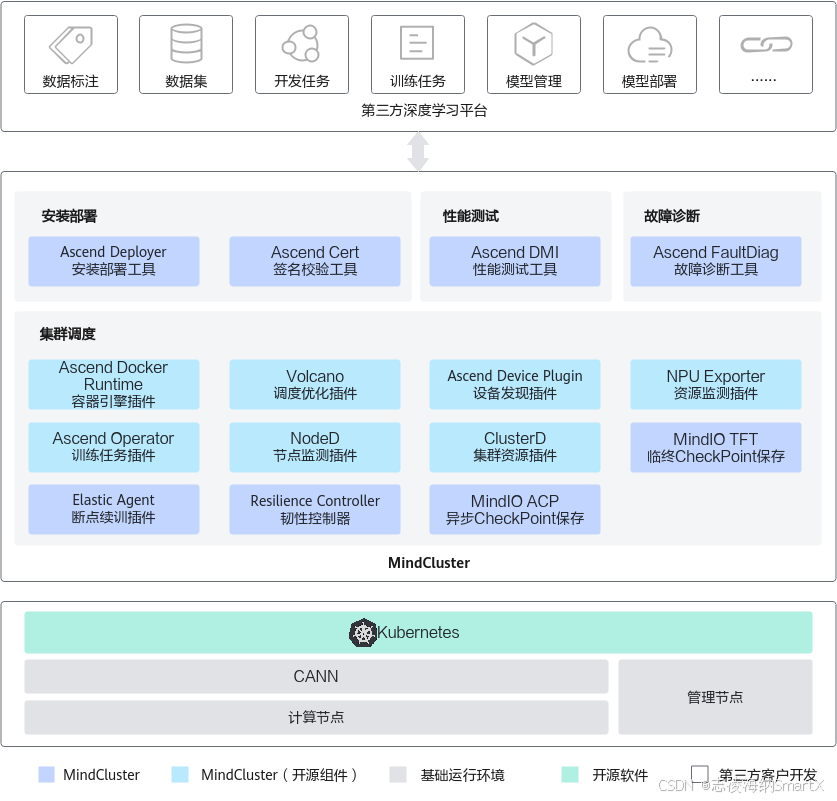

基于 SKS 部署

用户可以在基于 SmartX 超融合的虚拟机 Kubernetes 环境或裸金属 Kubernetes 环境中,通过昇腾推理硬件直通/纳管裸金属服务并搭配 MindCluster 集群调度组件,实现昇腾 NPU 与 MindIE 的部署与资源动态调度,快速构建基于昇腾生态的 AI 推理云原生框架,运行 DeepSeek 等大语言模型。简要步骤如下:

1.基础设施准备:

- 创建昇腾推理工作负载集群:用户可在 SKS 中快速创建带昇腾 NPU 的推理工作负载集群。

- 安装昇腾驱动:在 SKS 工作负载集群 worker 节点中安装昇腾 Ascend 驱动包,提供硬件基础支持。

2. MindCluster 集群调度组件部署:

- 拉取 MindCluster 组件镜像:昇腾镜像仓库提供 MindCluster 相关组件的镜像文件,用户可根据自己需要安装的组件拉取对应的镜像文件。

- 部署 MindCluster 组件:昇腾提供的 MindCluster 组件包包含基础必选模块和扩展可选模块,用户可根据实际业务需求选择安装。

3. 模型推理启动:

- MindIE MS 镜像制作:用户可通过昇腾官网提供的指导,根据自己的昇腾硬件制作 MindIE MS 镜像。

- 配置 MindIE MS 部署脚本:昇腾提供 MindIE MS 部署脚本,需要用户对 NPU 类型、NPU 数量、模型文件、模型参数等配置进行配置。

- 启动推理模型:运行部署脚本,实现自动下发业务配置和启动脚本,自动生成包含节点设备信息的 ranktable,并调度 Pod 到计算节点,运行 DeepSeek 等大语言模型。

部署验证-对接 Open WebUI

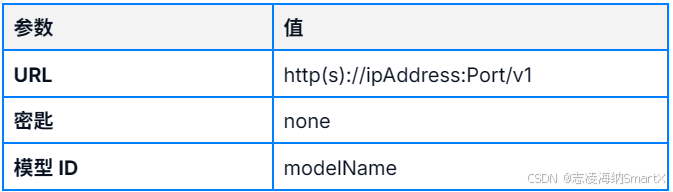

MindIE 兼容多种 RESTful 接口,用户可使用兼容 OpenAI 的接口对接 Open WebUI。对接时需要使用 MindIE 业务面的 IP 地址、端口和模型名称,即 config.json 文件中定义的”ipAddress”、“port”和“modelName”,参数如下所示:

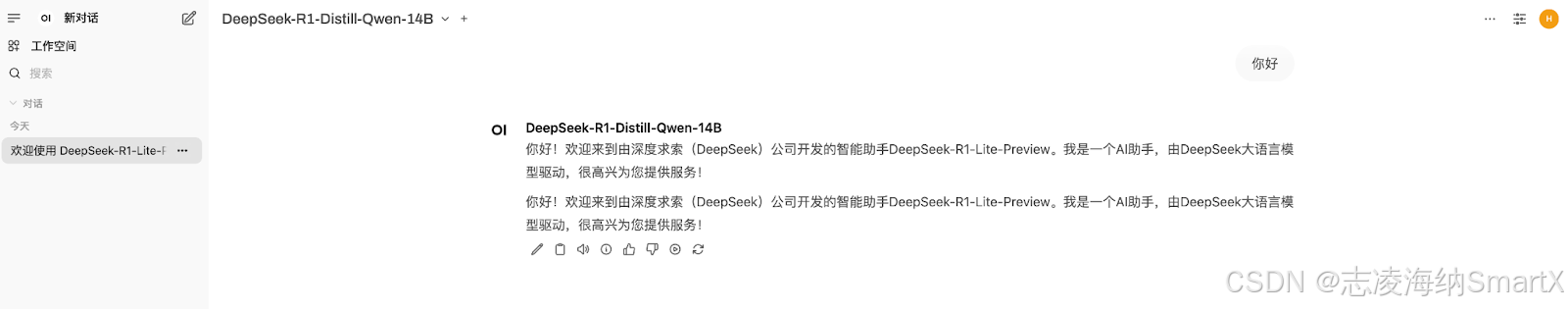

通过 Open WebUI 体验对接好的 DeepSeek-R1 模型效果如下:

SmartX AI 基础设施部署昇腾 NPU 的性能表现

环境配置

我们搭建了 3 节点 SmartX HCI 超融合集群,在虚拟机环境中基于 Atlas 300I Duo 推理卡搭建了 MindIE 推理平台,部署了 DeepSeek-R1-14B、32B 和 70B 模型并进行性能测试。

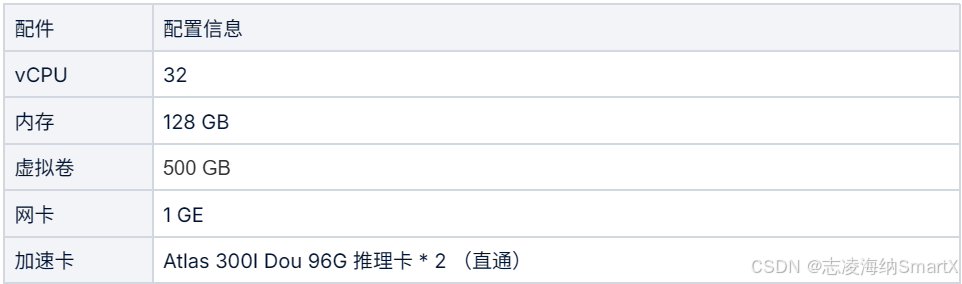

MindIE 虚拟机配置

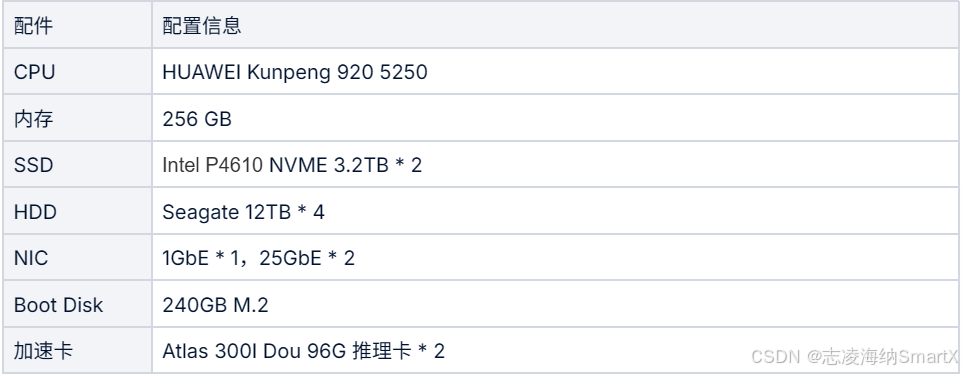

SMTX OS 集群硬件配置(以下为单节点配置)

测试结果

以上性能数据供大家参考。我们建议:

- 运行 DeepSeek-R1-32B 模型需要 2 张昇腾 300I Duo 推理卡,如果需要更高的并发能力,建议配置 4 张推理卡。

- 运行 DeepSeek-R1-70B 模型需要 4 张昇腾 300I Duo 推理卡,如果需要更高的并发能力,建议配置 8 张推理卡。

下载《构建企业 AI 基础设施:技术趋势、产品方案与测试验证》电子书,了解更多企业在 AI 大模型方面的部署验证与应用实践。

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)