驾驭不确定性:昇腾CANN中动态形状与Control Flow算子深度解析

例如,一个循环的次数取决于某个张量的值,这将导致不同AI Core可能执行不同的代码路径或循环次数,造成严重的线程发散(Thread Divergence)和性能下降。你将具备驾驭真实世界中那些充满不确定性的、更复杂、更前沿AI模型的核心能力,从而在AI系统工程师的道路上,迈向更高的台阶。),我们必须使用AI CPU来实现。如果你渴望从处理静态数据的“工匠”,成长为驾驭动态世界的“架构师”,那么,

前言

在CANN算子开发的入门阶段,我们通常在一个“乌托邦”式的世界里进行编程:输入张量的形状(Shape)是静态的、已知的、固定的。这使得我们可以进行完美的离线Tiling策略计算和内存规划。然而,当我们走出“新手村”,面对真实的、SOTA(State-of-the-Art)的AI模型时,会发现这个世界充满了“不确定性”。

- 在NLP领域,不同句子的长度(Sequence Length)天然就是动态的。

- 在计算机视觉中,目标检测模型的RoI Align操作,其输出的RoI数量是动态的。

- 在图神经网络(GNN)中,每个图的节点和边数量都是动态的。

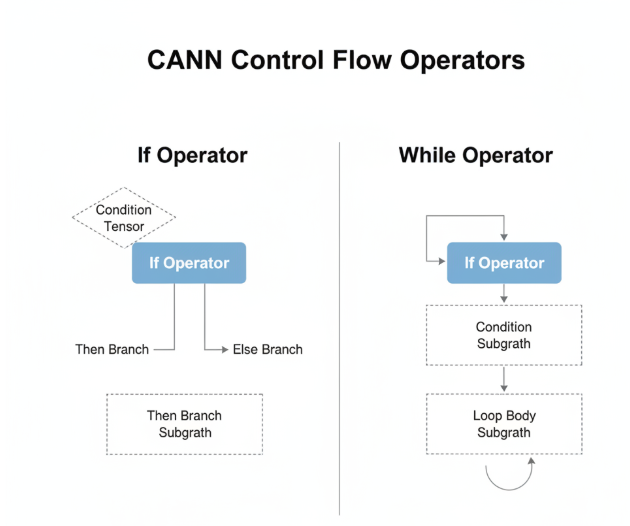

这种输入或中间张量的形状在运行时才能确定的特性,即动态形状(Dynamic Shape)。它对以静态规划见长的AI硬件(如NPU)提出了巨大的挑战。为了应对这种挑战,CANN不仅依赖于AI CPU的灵活性,还引入了一套专门的Control Flow(控制流)算子,如If, Case, While,将计算图从一条“直线”变成了可以“分支”和“循环”的复杂程序。

本文将带领你深入这个充满挑战与机遇的领域。我们将剖析动态形状带来的核心技术难题,并详细解析CANN是如何通过异构计算与Control Flow算子来构建解决方案的。

第一章:静态世界的崩塌 —— 动态形状的挑战

为了理解解决方案的精妙,我们必须先理解问题的棘手。动态形状对一个以“预编译”和“静态优化”为核心的AI计算框架,构成了三大根本性挑战:

-

内存规划的失效:

在静态形状下,CANN的图引擎可以在编译期精确地计算出每个中间张量需要多大的内存,并进行高效的内存复用。但在动态形状下,一个Tensor的大小在运行前是未知的。这就导致无法进行静态的内存规划,可能会带来频繁的动态内存分配/释放,产生大量内存碎片,甚至导致内存溢出(OOM)。 -

Tiling策略的延迟决策:

我们精心设计的Tiling策略,其核心参数(如blockLength)高度依赖于输入形状。如果形状是动态的,那么最优的Tiling策略也必须在运行时(Runtime)动态地计算出来。这要求TilingFunc的逻辑必须足够鲁棒和高效,以应对各种可能的输入尺寸。 -

并行模式的颠覆:

AI Core的大规模并行(SPMD)模型,建立在所有计算单元执行相同指令、处理规整数据的假设之上。而动态性,特别是数据依赖的控制流(Data-dependent Control Flow),会打破这一假设。例如,一个循环的次数取决于某个张量的值,这将导致不同AI Core可能执行不同的代码路径或循环次数,造成严重的线程发散(Thread Divergence)和性能下降。

第二章:CANN的应对之道 —— 异构计算与运行时决策

面对动态性的挑战,CANN的解决方案并非单一技术,而是一个系统性的、多层次的策略组合。

2.1 AI CPU:动态性的“第一响应者”

正如我们在之前的文章中探讨过的,AI CPU(板载ARM核心)是处理动态性的天然选择。对于输出形状依赖于输入数值的算子(如MaskedSelect, NonZero),我们必须使用AI CPU来实现。其开发范式(如两阶段并行算法)就是为了在运行时动态确定输出形状并分配内存。

2.2 运行时Tiling (Runtime Tiling)

对于那些输入形状可变,但计算逻辑依然规整的TBE算子(如动态尺寸的卷积),CANN采用运行时Tiling的策略。

- 编译期:

TilingFunc不再是简单地计算出一套固定的Tiling参数,而是被编译成一段更复杂的、包含条件判断的主机端(Host)程序。 - 运行时: 当一个具体形状的输入到来时,这段Host程序被执行。它会根据当前的输入Shape,实时地计算出最优的

TilingData,然后将其传递给已经编译好的、参数化的Device端核函数。

2.3 Control Flow算子:让计算图“活”起来

对于更复杂的、模型级别的动态性,CANN引入了专门的Control Flow算子,它们由图引擎(Graph Engine)在图层面进行解析和调度。

-

If/Case算子:实现条件分支- 功能: 类似于编程语言中的

if/else或switch/case。If算子接受一个布尔类型的cond张量作为输入,并包含两个子图(Subgraph):then_branch和else_branch。在运行时,图引擎会根据cond张量的实际数值,决定只执行其中一个子图。 - 应用场景: 在模型中实现动态网络结构。例如,根据输入图像的尺寸,决定是走一个“大模型”分支,还是一个“小模型”分支。

- 功能: 类似于编程语言中的

-

While算子:实现循环- 功能: 类似于

while循环。它包含两个子图:cond_graph(循环条件判断)和body_graph(循环体)。在每次迭代前,图引擎会先执行cond_graph,如果其输出为True,则执行一次body_graph,然后进入下一次迭代。 - 应用场景: 实现循环次数不固定的算法,如RNN(循环神经网络)的unrolling,或一些迭代式的优化算法。

- 功能: 类似于

第三章:Control Flow的执行与优化

Control Flow算子的引入,使得CANN的执行模型变得更加复杂和强大。

3.1 执行模型:子图的动态调度

当图引擎遇到一个Control Flow算子时,它并不会将整个模型的执行流打断。相反,它会将子图的调度,也作为异步任务来处理。

- 对于

If算子,图引擎会等待其cond输入张量计算完成,然后根据结果,将对应的then_branch或else_branch子图中的算子任务,提交到执行队列中。 - 对于

While算子,图引擎会构建一个控制流循环。在循环的每一步,它都会先调度cond_graph,同步等待其结果,然后根据结果决定是调度body_graph还是退出循环。

3.2 优化挑战与策略

Control Flow的引入也带来了新的优化挑战:

- 同步开销: 每次条件判断(如

While的循环条件),都可能引入一次主机与设备之间的同步,因为主机需要知道判断结果才能决定下一步做什么。 - 编译缓存失效: 如果子图内部的算子也受动态形状影响,可能会导致JIT编译缓存的反复失效和重编译。

CANN的优化策略:

- 图下沉(Graph Sinking): CANN会尽力将更多的控制逻辑下沉到设备端执行,减少主机的干预。例如,对于一些简单的循环,如果循环次数可以在设备端确定,整个循环都可以在一个大的核函数内部完成,而无需

While算->。 - 子图编译与缓存: 对

If和While的子图,CANN会尝试将其作为一个整体进行编译和优化,并对编译结果进行缓存,以减少重复编译的开销。 - 动态内存池: 为了应对动态形状带来的内存分配问题,CANN内部维护了一个复杂的动态内存管理池,通过高效的分配和回收算法,来减少内存碎片。

第四章:作为开发者,我们如何拥抱动态性?

-

优先选择异构方案: 当你面对一个具有动态输出形状的算子时,第一选择永远是AI CPU。它的开发模式天生就是为处理动态性和复杂逻辑而设计的。

-

编写鲁棒的TilingFunc: 当你必须为一个输入形状动态的TBE算子编写

TilingFunc时,你的代码必须:- 不包含任何硬编码(Hard-coded)的尺寸。所有计算都必须基于从

op.GetInputDesc()中获取的运行时Shape。 - 包含充分的边界条件检查,处理各种可能的极端情况(如某个维度为1,或总尺寸为0)。

- 逻辑尽可能高效,因为它会在每次调用时在主机端执行,其本身的耗时也会计入端到端延迟。

- 不包含任何硬编码(Hard-coded)的尺寸。所有计算都必须基于从

-

理解而非滥用Control Flow:

- Control Flow算子是解决模型级动态性的强大武器,但不应该被用来实现算子级的细粒度控制逻辑。

- 在设计模型时,如果能通过数学变换,将一个需要

If/While的动态结构,转换成一个等价的、静态的批处理(Batching)操作,后者通常会拥有高得多的性能。

结论

从静态到动态,是AI模型发展的必然趋势,也是对AI计算平台成熟度的终极考验。CANN通过一套**“AI CPU主内,TBE算能,Control Flow主外”**的组合拳,系统性地应对了动态形状带来的挑战。

- AI CPU负责解决最棘手的、数据依赖的动态输出问题。

- TBE的运行时Tiling负责处理输入形状可变但计算模式规整的核心性能算子。

- Control Flow算子负责在图层面实现模型级的动态分支与循环。

作为CANN开发者,理解并掌握这套异构的、动态的编程范式,意味着你将不再局限于处理“实验室”里的理想化问题。你将具备驾驭真实世界中那些充满不确定性的、更复杂、更前沿AI模型的核心能力,从而在AI系统工程师的道路上,迈向更高的台阶。

驾驭不确定性的实战演练场:

理论的深度需要反复的实践来巩固。2025年昇腾CANN训练营第二季为你提供了绝佳的实践机会:

- 开发者案例: 学习在真实的工业模型中,动态形状和Control Flow是如何被应用的。

- 官方技术支持与社区: 与顶尖工程师交流,探讨处理动态性的最佳实践。

- 权威技能认证: Ascend C中级认证,证明你具备了处理复杂AI模型的全栈能力。

- 丰富的实践激励: 完成任务更有机会赢取华为手机、平板、开发板等大奖。

如果你渴望从处理静态数据的“工匠”,成长为驾驭动态世界的“架构师”,那么,现在就是启程的最佳时机。

报名链接: https://www.hiascend.com/developer/activities/cann20252

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)