昇思25天学习打卡营第5天 | 网络构建

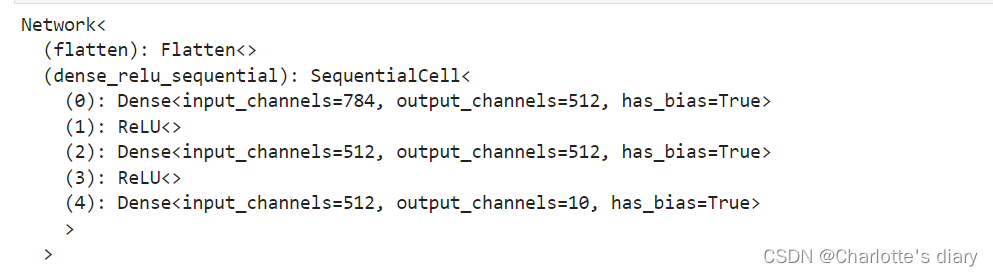

定义神经网络时,可以继承nn.Cell类,在__init__方法中进行子Cell的实例化和状态管理,在construct方法中实现Tensor操作。construct意为神经网络(计算图)构建构建完成后,实例化Network对象,并查看其结构:三个全连接层(Dense)和两个ReLU激活函数的序列模型nn.ReLU(),nn.ReLU(),我们构造一个输入数据,直接调用模型,可以获得一个十维的Te

目录

神经网络模型是由神经网络层和Tensor操作构成的,

mindspore.nn提供了常见神经网络层的实现,

在MindSpore中,Cell类是构建所有网络的基类,也是网络的基本单元。

一个神经网络模型表示为一个Cell,它由不同的子Cell构成。

使用这样的嵌套结构,可以简单地使用面向对象编程的思维,对神经网络结构进行构建和管理。

1.定义模型类

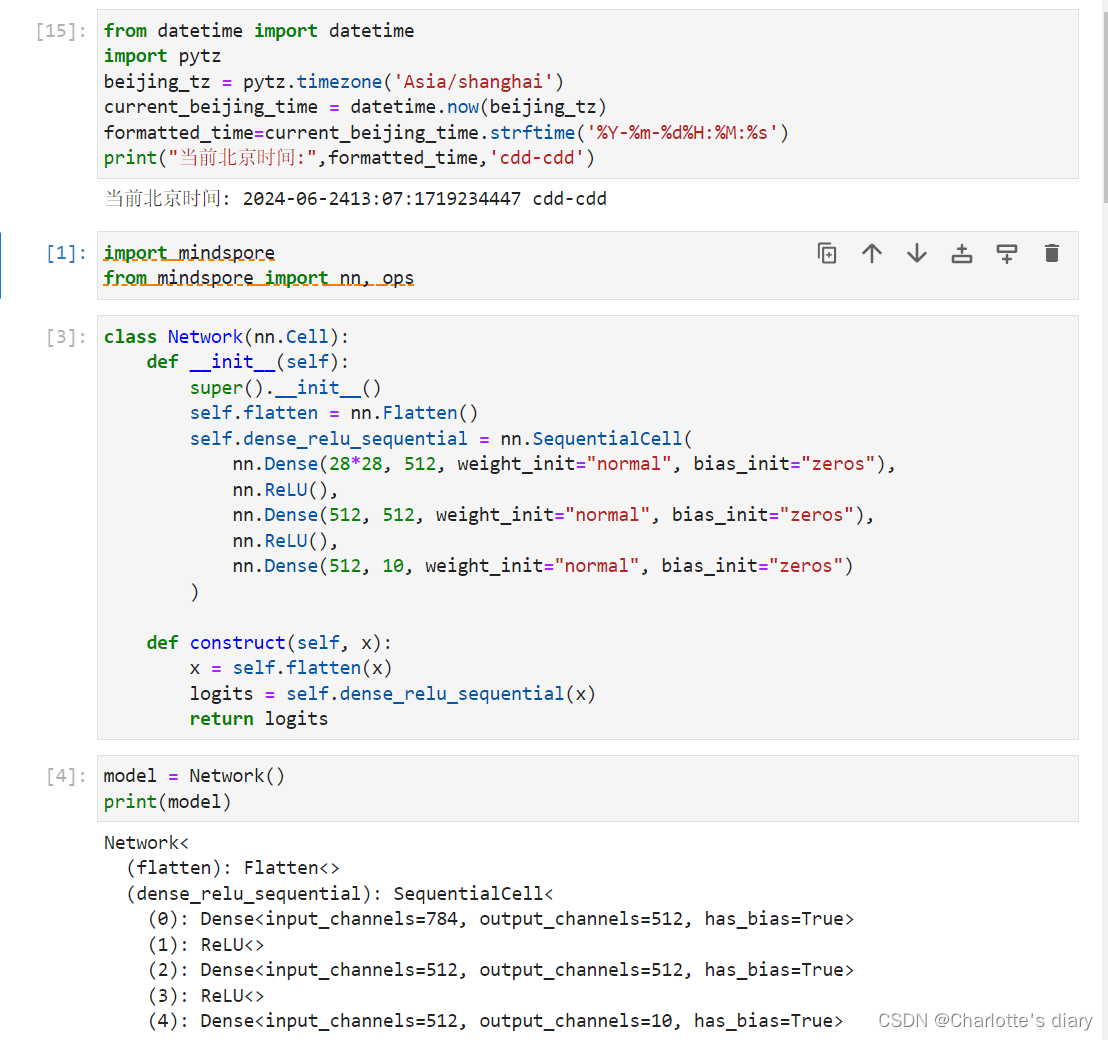

定义神经网络时,可以继承nn.Cell类,在__init__方法中进行子Cell的实例化和状态管理,在construct方法中实现Tensor操作。

construct意为神经网络(计算图)构建

构建完成后,实例化Network对象,并查看其结构:

三个全连接层(Dense)和两个ReLU激活函数的序列模型

class Network(nn.Cell):

def __init__(self):

super().__init__()

self.flatten = nn.Flatten()

self.dense_relu_sequential = nn.SequentialCell(

nn.Dense(28*28, 512, weight_init="normal", bias_init="zeros"),

nn.ReLU(),

nn.Dense(512, 512, weight_init="normal", bias_init="zeros"),

nn.ReLU(),

nn.Dense(512, 10, weight_init="normal", bias_init="zeros")

)

def construct(self, x):

x = self.flatten(x)

logits = self.dense_relu_sequential(x)

return logits

model = Network()

print(model)

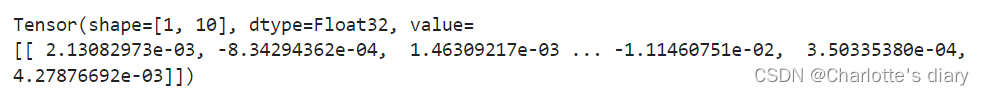

我们构造一个输入数据,直接调用模型,可以获得一个十维的Tensor输出,其包含每个类别的原始预测值。

model.construct()方法不可直接调用。在此基础上,我们通过一个

nn.Softmax层实例来获得预测概率。

X = ops.ones((1, 28, 28), mindspore.float32)

logits = model(X)

# print logits

logits

pred_probab = nn.Softmax(axis=1)(logits)

y_pred = pred_probab.argmax(1)

print(f"Predicted class: {y_pred}")

![]()

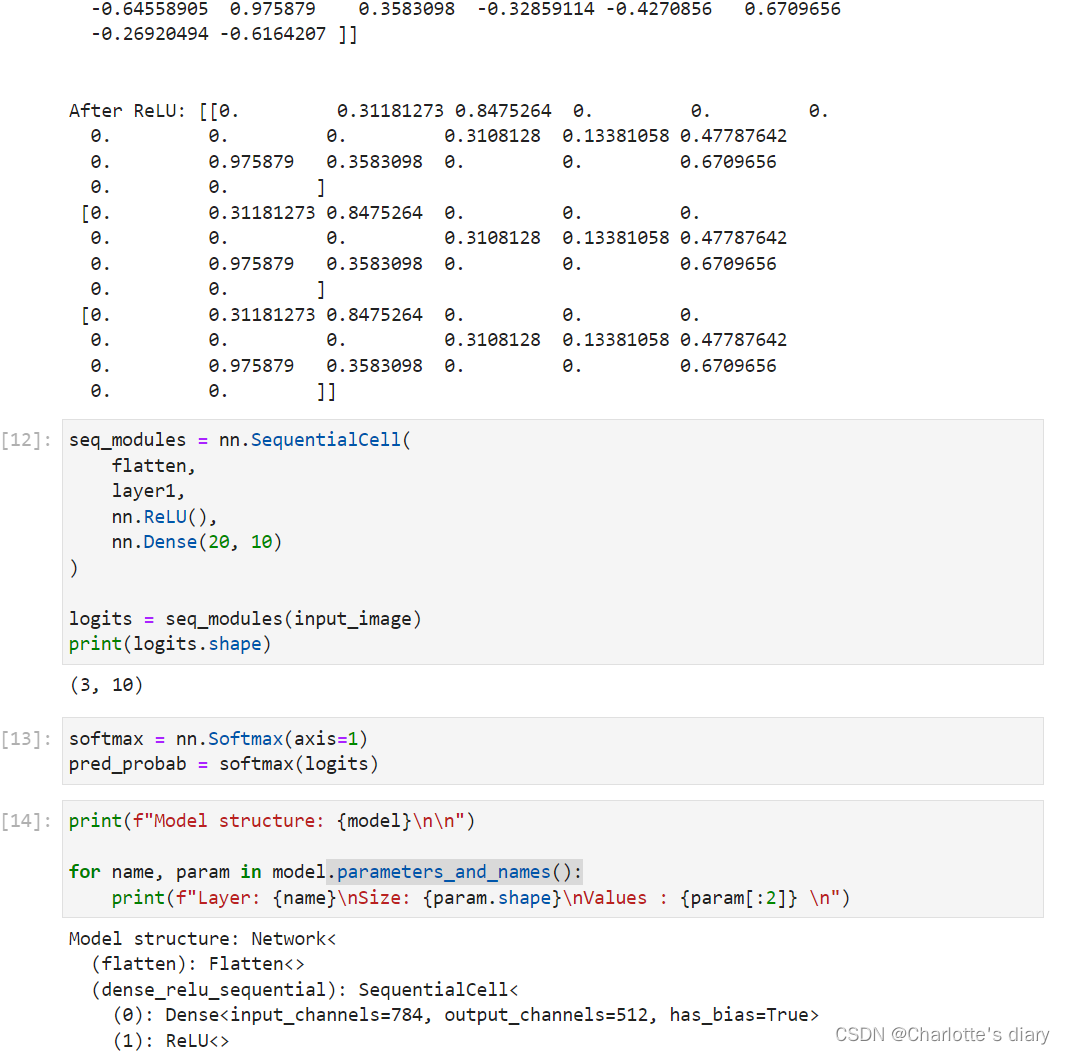

2.模型层

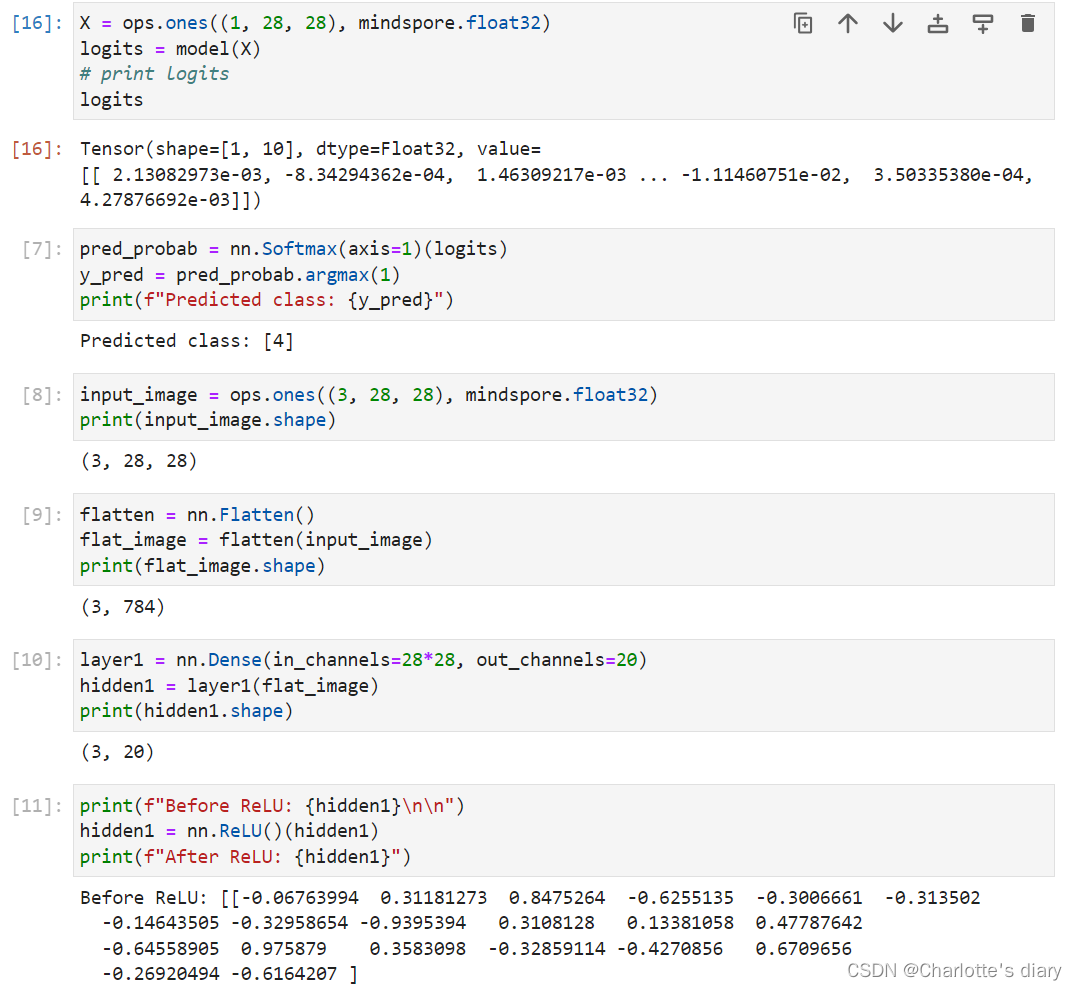

我们分解上面构造的神经网络模型中的每一层。首先我们构造一个shape为(3, 28, 28)的随机数据(3个28x28的图像),依次通过每一个神经网络层来观察其效果。

input_image = ops.ones((3, 28, 28), mindspore.float32)

print(input_image.shape)

nn.Flatten

实例化nn.Flatten层,将28x28的2D张量转换为784大小的连续数组。

nn.Dense

nn.Dense为全连接层,其使用权重和偏差对输入进行线性变换。

nn.ReLU

nn.ReLU层给网络中加入非线性的激活函数,帮助神经网络学习各种复杂的特征。

nn.SequentialCell

nn.SequentialCell是一个有序的Cell容器。输入Tensor将按照定义的顺序通过所有Cell。我们可以使用

SequentialCell来快速组合构造一个神经网络模型。

nn.Softmax

最后使用nn.Softmax将神经网络最后一个全连接层返回的logits的值缩放为[0, 1],表示每个类别的预测概率。

axis指定的维度数值和为1。

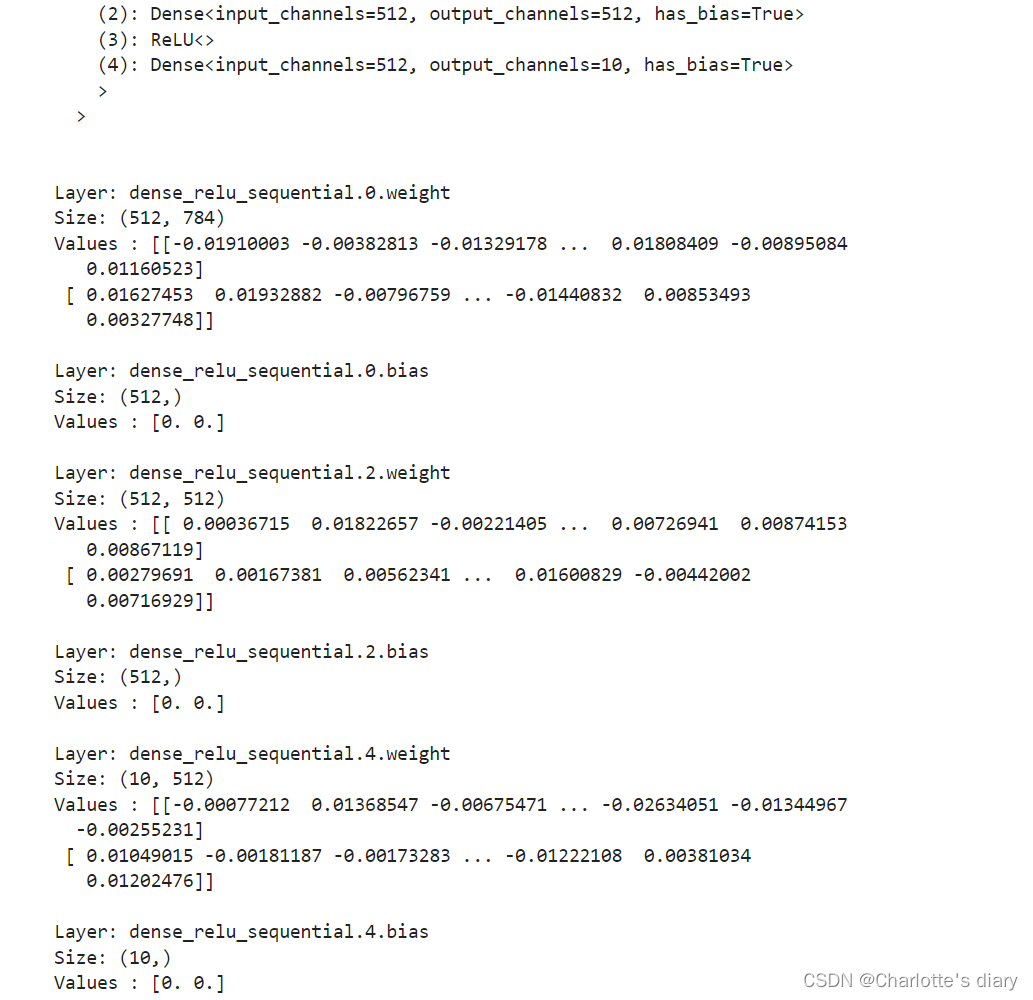

3.模型参数

网络内部神经网络层具有权重参数和偏置参数(如nn.Dense),这些参数会在训练过程中不断进行优化,可通过 model.parameters_and_names() 来获取参数名及对应的参数详情。

代码实现:

总结

构建网络,定义模型类时,要有这个框架,继承类,在他里面进行实例化和状态管理:

class Network(nn.Cell): 定义了一个类,继承自nn.Cell。

def __init__(self):Network类的构造函数,初始化类的属性。

super().__init__(): 调用父类nn.Cell的构造函数。

def construct(self, x): 定义了Network类的construct方法,它是MindSpore中定义模型前向传播逻辑的方法。参数x表示输入数据。

x = self.flatten(x): 使用self.flatten层将输入数据x展平。

logits = self.dense_relu_sequential(x): 将展平后的数据x通过self.dense_relu_sequential序列模型进行前向传播,得到模型的原始输出logits。在分类任务中,logits是模型的线性输出

return logits: 返回模型的输出logits。

class Network(nn.Cell):

def __init__(self):

super().__init__()

def construct(self, x):

x = self.flatten(x)

logits = self.dense_relu_sequential(x)

return logits

self.flatten = nn.Flatten(): 初始化一个nn.Flatten层,这个层用于将多维输入数据展平为一维数据。在处理图像数据时,通常需要将图像的二维数据(例如,28x28像素)展平为一维向量。

self.dense_relu_sequential = nn.SequentialCell(...): 初始化一个序列模型,包含三个全连接层(nn.Dense)和两个ReLU激活函数(nn.ReLU)。这个序列模型的初始化与之前解释的相同。

预测的时候:

1. pred_probab = nn.Softmax(axis=1)(logits): 使用了nn.Softmax函数来将模型的输出logits转换为概率分布。

Softmax函数通常用于多类分类问题的输出层,它可以将一个向量的元素转换为一个概率分布,使得所有元素的和为1。参数

axis=1表示Softmax函数将在第二个维度(通常是特征维度)上应用,即对于每个样本,将其对应的logits转换为概率。

2. y_pred = pred_probab.argmax(1): 这行代码使用了argmax函数来找到每个样本概率最高的类别索引。argmax函数返回输入数组中最大元素的索引。在这里,它沿着第二个维度(即每个样本的概率分布)找到最大值的索引,这代表了模型预测的类别。

pred_probab = nn.Softmax(axis=1)(logits)

y_pred = pred_probab.argmax(1)

print(f"Predicted class: {y_pred}")别的也没什么了吧~~~

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)