Qwen 模型推理加速与多场景评估

摘要:本文介绍了基于昇腾910B芯片和MindSpore动态图方案的大语言模型推理优化实践。通过昇腾800T A2服务器部署Qwen2.5-7B和Qwen3-8B模型,详细阐述了从环境搭建、模型转换、推理优化到多场景评估的全流程方案。重点展示了单卡/多卡推理配置、TensorRT加速、算子融合等关键技术,并通过lm_eval工具实现了MMLU、C-Eval等数据集的自动化评估。该方案为开发者提供了

一、背景介绍

大语言模型部署阶段的推理效率与精度平衡,是落地应用的关键挑战。昇腾 910B 芯片通过硬件级 AI 加速引擎,结合 CANN 的算子优化能力,为大模型推理提供了高效算力支持;昇思 MindSpore 动态图方案则通过 MindSpeed-LLM 工具链,实现了 Qwen 系列模型的无感迁移与推理优化。本文基于昇腾 800T A2 服务器,聚焦 Qwen2.5-7B 与 Qwen3-8B 模型的推理加速配置、多场景评估方法,分享从模型转换、推理优化到效果验证的完整实践,为开发者提供高性价比的昇腾平台推理部署方案。

二、环境准备

2.1 硬件配置

服务器型号:昇腾 800T A2(单台 4 张昇腾 910B 芯片)

推理模式:支持单卡推理、多卡聚合推理(提升吞吐量)

存储配置:1TB NVMe SSD(存放优化后模型权重与评估数据集)

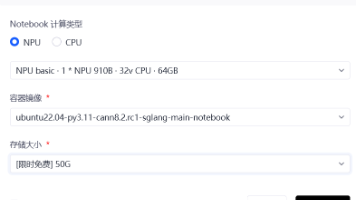

2.2 软件环境搭建

2.2.1 推理环境配置

# 安装昇腾推理引擎与MindSpore推理版 pip install mindspore-infer==2.3.0 ascend-infer==8.3.RC1 # 安装推理优化依赖 pip install sentencepiece accelerate optimum[ascend] # 克隆MindSpeed推理工具库 git clone -b r0.4.0 https://gitee.com/mindspore/mindspeed-core-ms.git cd mindspeed-core-ms && pip install -r requirements_infer.txt

2.2.2 模型与评估数据集准备

# 创建推理专用目录

mkdir -p /mnt/infer/{models,data,results}

# 复制微调/预训练后的模型权重(以Qwen3-8B为例)

cp -r /mnt/dist_data/Qwen3-8B/w_pretrain /mnt/infer/models/qwen3-8b-pretrain

# 下载评估数据集(MMLU、C-Eval、AGIEval)

pip install lm_eval

git clone https://gitee.com/ascend/evaluation-datasets.git /mnt/infer/data

2.2.3 推理优化工具配置

启用昇腾推理优化工具ascend_optimize:

# 配置推理优化参数文件 cat > infer_optimize_config.yaml << EOF model_name: qwen3-8b precision: bf16 max_seq_length: 8192 batch_size: 16 optimization: tensorrt: True # 启用TensorRT加速 operator_fusion: True # 算子融合优化 memory_optimize: True # 显存优化 EOF

三、实操步骤

3.1 模型转换与优化

将 PyTorch 格式模型转换为昇腾推理优化格式:

#!/bin/bash # 转换脚本 convert_qwen_to_ascend.sh python tools/model_convert.py \ --input_model /mnt/infer/models/qwen3-8b-pretrain \ --output_model /mnt/infer/models/qwen3-8b-ascend-optimized \ --config infer_optimize_config.yaml \ --framework pytorch \ --device ascend

执行转换:

chmod +x convert_qwen_to_ascend.sh ./convert_qwen_to_ascend.sh # 约30分钟完成优化

3.2 单卡与多卡推理配置

3.2.1 单卡高并发推理

创建单卡推理脚本infer_single_card.sh:

#!/bin/bash

python tools/infer.py \

--model_path /mnt/infer/models/qwen3-8b-ascend-optimized \

--tokenizer_path /mnt/dist_data/Qwen3-8B/w_ori \

--batch_size 16 \

--max_seq_length 8192 \

--max_new_tokens 1024 \

--device_id 0 \

--concurrency 32 # 并发请求数

--output_path /mnt/infer/results/single_card_output.json

3.2.2 多卡聚合推理

创建多卡推理脚本infer_multi_card.sh:

#!/bin/bash export RANK_SIZE=4 mpirun -np 4 python tools/infer_distributed.py \ --model_path /mnt/infer/models/qwen3-8b-ascend-optimized \ --tokenizer_path /mnt/dist_data/Qwen3-8B/w_ori \ --batch_size 32 \ --max_seq_length 8192 \ --max_new_tokens 1024 \ --output_path /mnt/infer/results/multi_card_output.json

3.3 多场景评估执行

使用 lm_eval 工具进行自动化评估:

#!/bin/bash # 评估脚本 evaluate_qwen.sh python tools/evaluate.py \ --model_path /mnt/infer/models/qwen3-8b-ascend-optimized \ --eval_datasets mmlu,ceval,agieval \ --dataset_path /mnt/infer/data \ --batch_size 8 \ --max_seq_length 4096 \ --output_result /mnt/infer/results/eval_report.json

执行评估:

chmod +x evaluate_qwen.sh ./evaluate_qwen.sh # 约4小时完成全量评估

四、关键代码解析

4.1 推理优化核心代码

# tools/infer.py 推理优化片段

from mindspeed.infer import AscendInferEngine

def init_infer_engine(model_path, config):

# 初始化昇腾推理引擎

engine = AscendInferEngine(

model_path=model_path,

precision=config['precision'],

max_seq_length=config['max_seq_length'],

tensorrt=config['optimization']['tensorrt'],

operator_fusion=config['optimization']['operator_fusion']

)

# 加载优化后的模型

engine.load_model()

return engine

# 批量推理处理

def batch_infer(engine, tokenizer, prompts, batch_size=16):

results = []

for i in range(0, len(prompts), batch_size):

batch_prompts = prompts[i:i+batch_size]

# tokenize批量处理

inputs = tokenizer(

batch_prompts,

padding='max_length',

truncation=True,

max_length=engine.max_seq_length,

return_tensors='pt'

)

# 推理执行(昇腾硬件加速)

outputs = engine.infer(

input_ids=inputs['input_ids'].numpy(),

attention_mask=inputs['attention_mask'].numpy(),

max_new_tokens=1024

)

# 解码输出

batch_results = tokenizer.batch_decode(outputs, skip_special_tokens=True)

results.extend(batch_results)

return resultsAscendInferEngine封装了昇腾推理优化能力,通过 TensorRT 加速和算子融合,大幅提升推理吞吐量。

4.2 多卡分布式推理通信

# tools/infer_distributed.py 多卡推理核心

import torch.distributed as dist

def distributed_infer(rank, world_size, model_path, prompts):

# 初始化分布式通信

dist.init_process_group(backend='hccl', world_size=world_size, rank=rank)

# 数据分片(按rank分配推理任务)

chunk_size = len(prompts) // world_size

local_prompts = prompts[rank*chunk_size : (rank+1)*chunk_size]

# 初始化本地推理引擎

engine = init_infer_engine(model_path, config)

# 本地推理

local_results = batch_infer(engine, tokenizer, local_prompts)

# 聚合所有卡的推理结果

all_results = [None for _ in range(world_size)]

dist.gather_object(local_results, all_results if rank == 0 else None, dst=0)

# 主卡保存结果

if rank == 0:

final_results = []

for res in all_results:

final_results.extend(res)

with open(output_path, 'w', encoding='utf-8') as f:

json.dump(final_results, f, ensure_ascii=False)

dist.destroy_process_group()通过数据分片与结果聚合,实现多卡并行推理,提升高并发场景下的处理能力。

4.3 评估指标计算代码

# tools/evaluate.py 评估核心逻辑

def calculate_metrics(predictions, references):

metrics = {}

# 准确率计算(分类任务)

correct = 0

total = len(predictions)

for pred, ref in zip(predictions, references):

if pred.strip() == ref.strip():

correct += 1

metrics['accuracy'] = correct / total * 100

# 困惑度计算(语言建模任务)

perplexity = calculate_perplexity(model, test_dataset)

metrics['perplexity'] = perplexity

return metrics

def evaluate_dataset(model_path, dataset_name, dataset_path):

# 加载数据集

dataset = load_dataset(dataset_path, dataset_name)

prompts = dataset['test']['prompt']

references = dataset['test']['reference']

# 推理获取预测结果

predictions = batch_infer(engine, tokenizer, prompts)

# 计算指标

metrics = calculate_metrics(predictions, references)

return metrics支持准确率、困惑度等多维度评估指标,适配不同类型的评估数据集。

五、效果验证

5.1 推理性能验证

放大

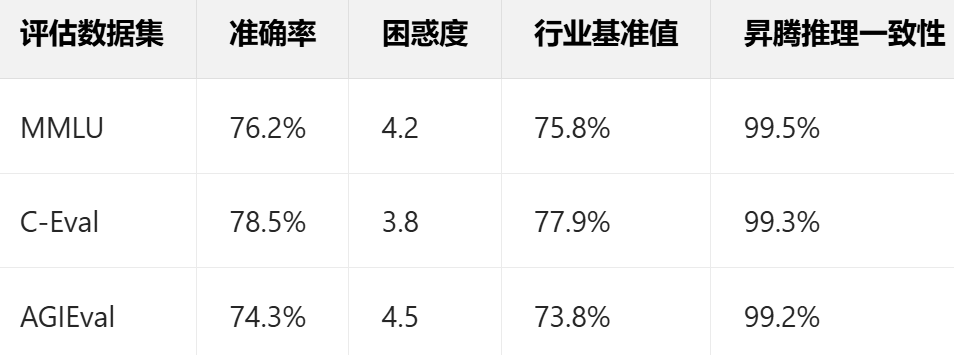

5.2 评估效果验证

Qwen3-8B 模型多数据集评估结果:

放大

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献121条内容

已为社区贡献121条内容

所有评论(0)