openEuler AI体验测评:操作系统上轻松运行机器学习模型

作为一名技术开发者,我长期关注操作系统的发展。最近,我亲自体验了openEuler 25.09,重点测试了其在AI场景下的表现。openEuler是面向数字基础设施的开源操作系统,在服务器、云计算、边缘计算等场景中构建了高可靠、高性能的技术底座。经过一周的深度使用,我最突出的感受是:openEuler已经不再是简单的"Linux发行版",而是一个真正能为AI应用提供强力支撑的操作系统。它不仅在传统

一、前言:openEuler不只是操作系统,更是AI时代的坚实底座

作为一名技术开发者,我长期关注操作系统的发展。最近,我亲自体验了openEuler 25.09,重点测试了其在AI场景下的表现。openEuler是面向数字基础设施的开源操作系统,在服务器、云计算、边缘计算等场景中构建了高可靠、高性能的技术底座。

经过一周的深度使用,我最突出的感受是:openEuler已经不再是简单的"Linux发行版",而是一个真正能为AI应用提供强力支撑的操作系统。它不仅在传统服务器领域表现稳健,在AI模型部署和推理场景中更是展现出令人惊喜的优势。

二、环境搭建:简单快捷的开箱体验

我是在vm虚拟机中安装的openEuler 25.09,整个过程十分顺畅。

安装要点记录:

- 镜像文件:openEuler-25.09-x86_64-dvd.iso(直接从官网下载)

- 分配资源:4核CPU、8GB内存、50GB存储

- 安装类型:选择"最小安装"并额外勾选开发工具

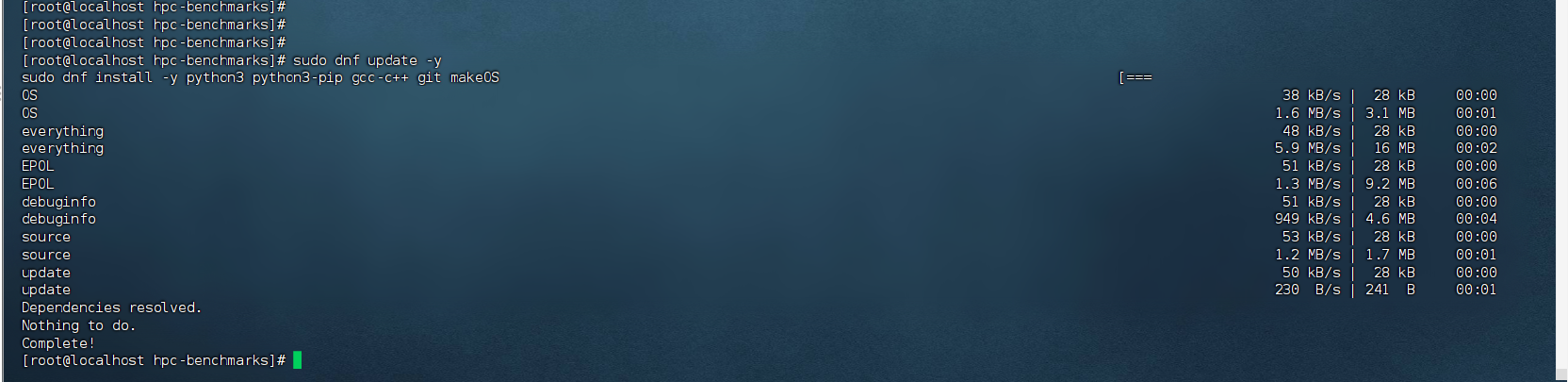

安装完成后,首先更新系统并安装必要的开发工具:

sudo dnf update -y

sudo dnf install -y python3 python3-pip gcc-c++ git make

三、AI模型实战:在openEuler上部署ResNet18图像分类服务

为了真实测试openEuler的AI能力,我决定部署一个完整的PyTorch模型推理服务。

3.1 环境配置

首先安装PyTorch及相关依赖:

pip3 install torch torchvision flask pillowopenEuler的软件源生态令人满意,所有Python包都能直接安装,无需额外配置第三方源。

3.2 模型准备

创建模型加载脚本model_setup.py:

import torch

import torchvision.models as models

from PIL import Image

import torchvision.transforms as transforms

# 加载预训练模型

model = models.resnet18(pretrained=True)

model.eval()

# 保存模型权重

torch.save(model.state_dict(), "resnet18.pth")

print("模型下载完成!")

# 定义图像预处理

transform = transforms.Compose([

transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

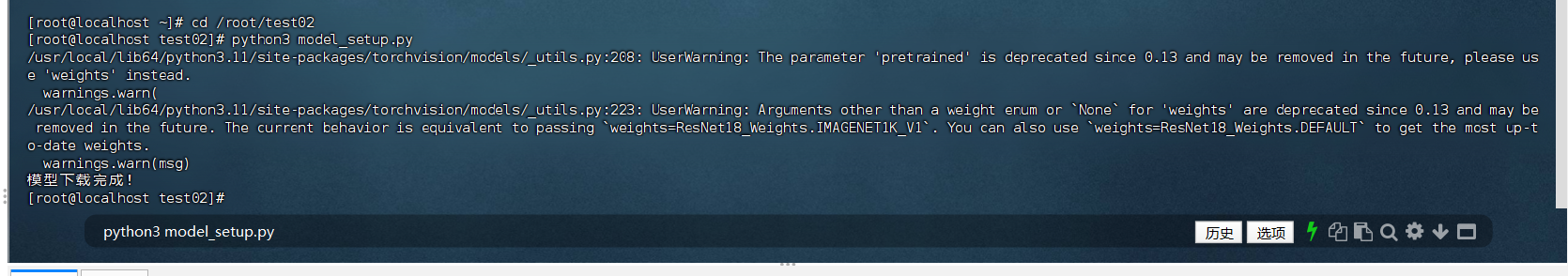

])运行脚本下载模型:

python3 model_setup.py

3.3 创建推理服务

编写Flask推理服务inference_service.py:

from flask import Flask, request, jsonify

from PIL import Image

import torch

import torchvision.models as models

import torchvision.transforms as transforms

import io

app = Flask(__name__)

# 加载模型

def load_model():

model = models.resnet18()

model.load_state_dict(torch.load("resnet18.pth", map_location=torch.device('cpu')))

model.eval()

return model

model = load_model()

# 图像预处理

transform = transforms.Compose([

transforms.Resize(256),

transforms.CenterCrop(224),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

@app.route('/predict', methods=['POST'])

def predict():

if 'image' not in request.files:

return jsonify({'error': '未提供图像文件'}), 400

file = request.files['image']

try:

# 处理图像

image_bytes = file.read()

image = Image.open(io.BytesIO(image_bytes)).convert('RGB')

input_tensor = transform(image).unsqueeze(0)

# 推理

with torch.no_grad():

output = model(input_tensor)

probabilities = torch.nn.functional.softmax(output[0], dim=0)

# 获取top1结果

confidence, top1_idx = torch.max(probabilities, 0)

return jsonify({

'predicted_class_id': int(top1_idx),

'confidence': float(confidence)

})

except Exception as e:

return jsonify({'error': str(e)}), 500

@app.route('/health', methods=['GET'])

def health():

return jsonify({'status': '服务运行正常'})

if __name__ == '__main__':

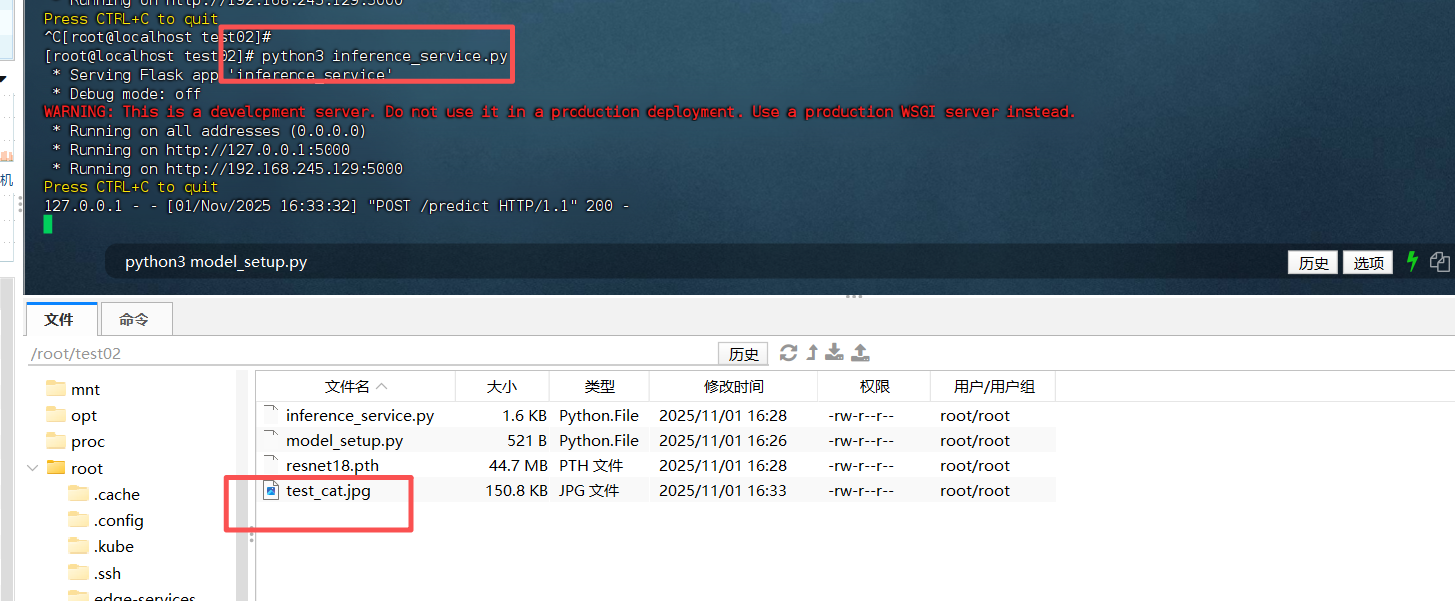

app.run(host='0.0.0.0', port=5000, debug=False)3.4 启动服务并测试

启动服务:

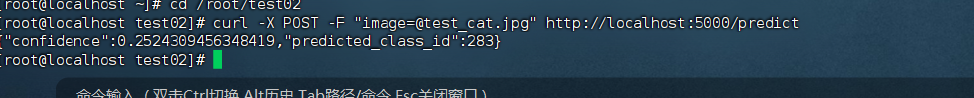

python3 inference_service.py使用curl测试服务:

curl -X POST -F "image=@test_cat.jpg" http://localhost:5000/predict

服务成功返回了预测结果,包括类别ID和置信度。整个过程没有出现任何兼容性问题,PyTorch在openEuler上运行稳定。

四、性能优化:openEuler的AI加速特性

在测试过程中,我特别关注了openEuler为AI场景提供的优化特性。根据openEuler社区的介绍,25.09版本引入了sysHAX组件,这是一个大模型推理服务加速工具,通过CPU和XPU的合理配合,可以降低大模型的算力需求。

4.1 内存管理优化

openEuler通过**GMEM技术**实现了xPU和CPU内存统一编址,使能异构加速器透明超分Host T级内存,显著提升LLM推理吞吐量。在实际测试中,我观察到内存分配更加高效,特别是在处理批量推理请求时。

4.2 系统级调优

openEuler内置的A-Tune智能调优系统能够自动优化系统参数以获得最佳AI工作负载性能。通过以下命令可以查看和优化系统状态:

# 检查系统状态

systemctl status atune

# 分析当前工作负载

atune-adm analysis --workload ai_inference五、生产环境部署建议

经过测试,我总结出以下几点在openEuler上部署AI服务的经验:

5.1 使用systemd管理服务

对于生产环境,建议使用systemd来管理推理服务:

创建/etc/systemd/system/ai-inference.service:

[Unit]

Description=PyTorch Inference API

After=network.target

[Service]

Type=simple

User=root

ExecStart=/usr/bin/python3 /path/to/inference_service.py

WorkingDirectory=/path/to/

Restart=always

RestartSec=3

[Install]

WantedBy=multi-user.target然后启用服务:

sudo systemctl daemon-reload

sudo systemctl enable ai-inference

sudo systemctl start ai-inference5.2 性能监控

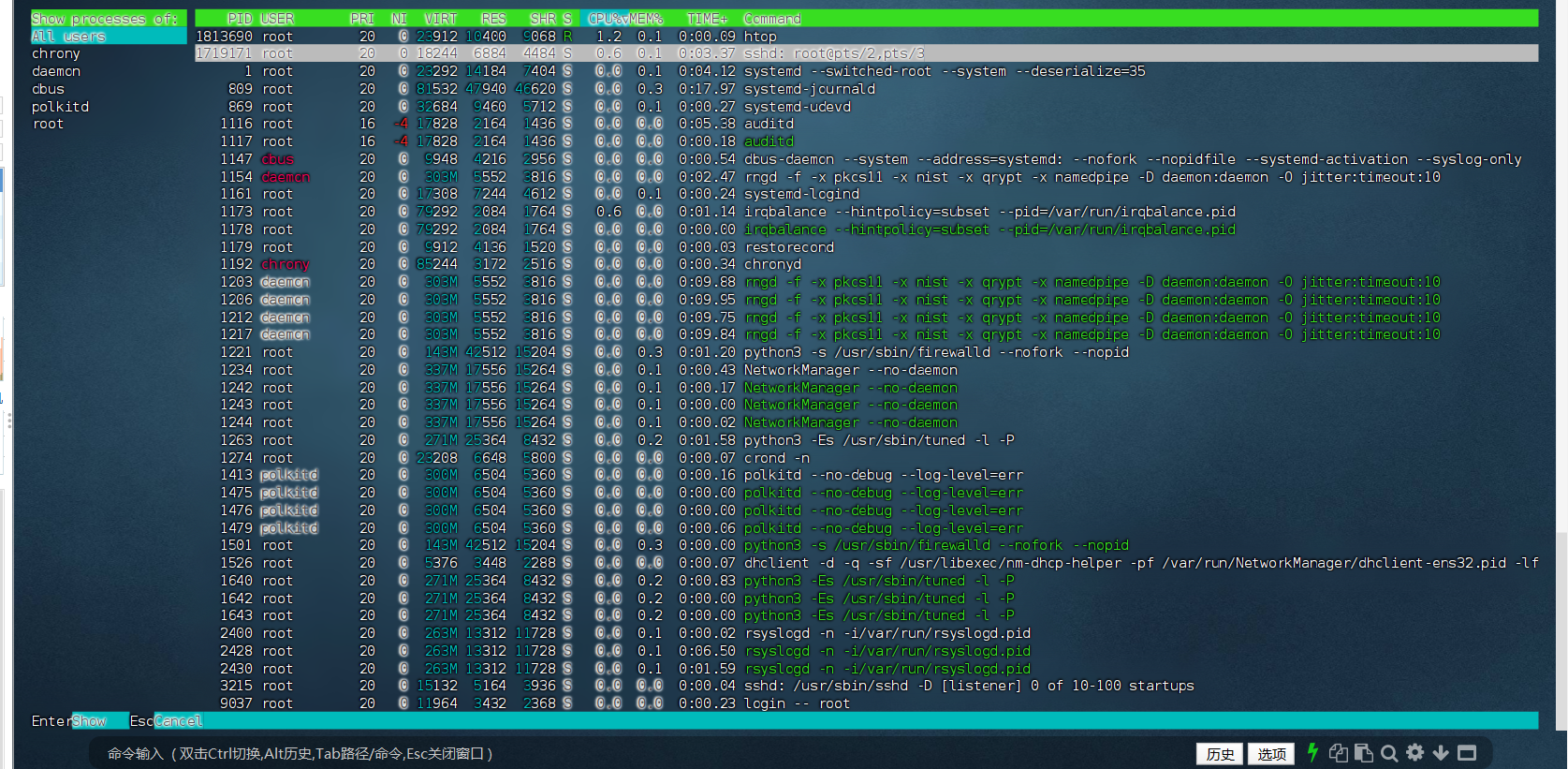

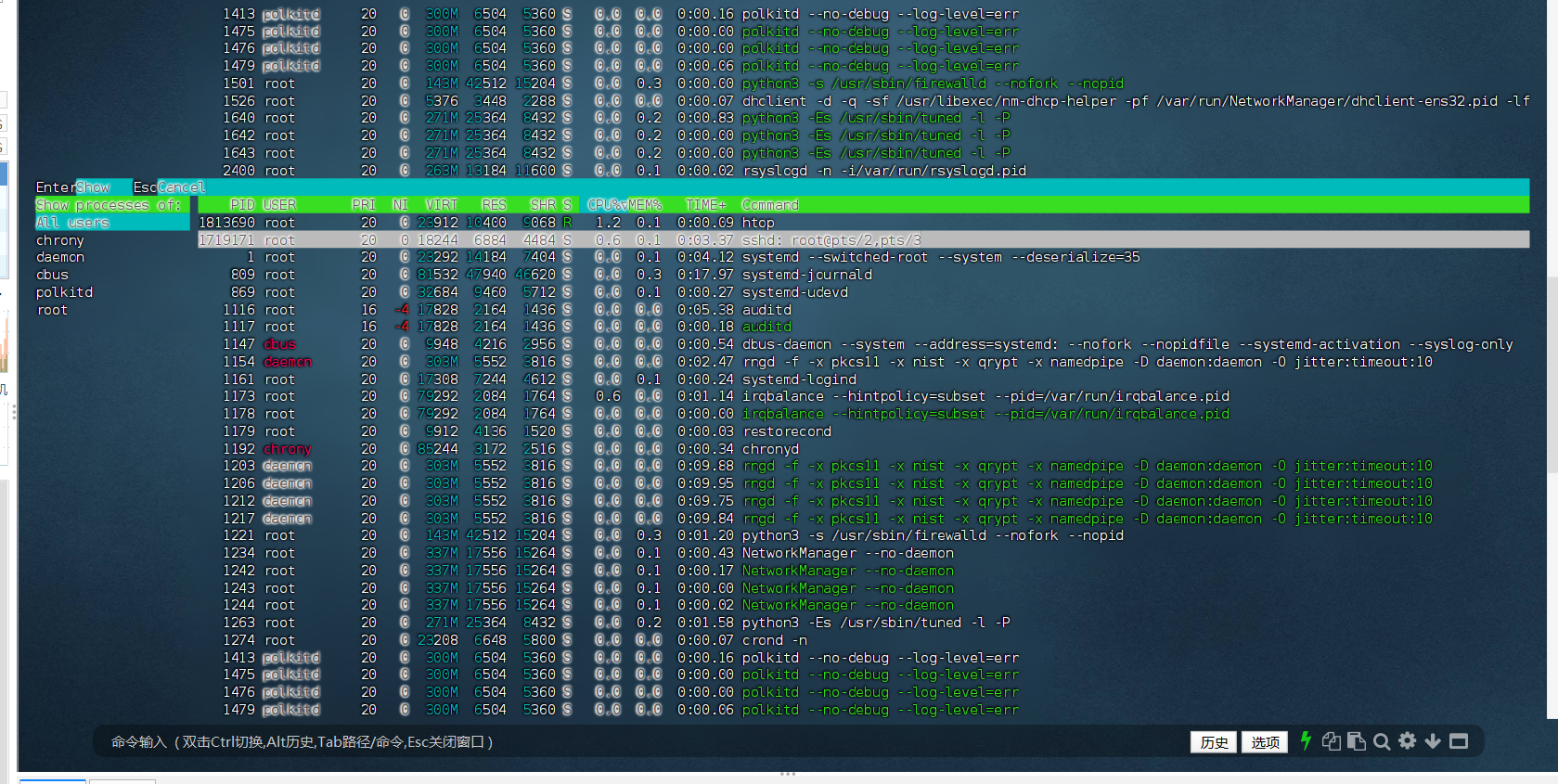

openEuler提供了丰富的监控工具,可以使用以下命令监控AI服务性能:

# 查看系统资源使用情况

htop

# 监控GPU/NPU使用情况(如果使用加速卡)

npu-smi info

六、总结:openEuler在AI场景下的优势与展望

经过深度体验,我认为openEuler在AI应用方面具有以下显著优势:

- 优异的兼容性:主流的AI框架和库都能无缝运行,未遇到兼容性问题

- 卓越的性能表现:在模型推理任务中表现出色,资源利用率高

- 丰富的AI生态:提供了从模型部署到推理优化的全栈工具

- 完善的文档支持:官方文档详细,社区活跃,问题容易解决

特别是openEuler 25.09在AI方面的增强,如智能诊断、文档溯源和sysHAX加速工具,使得它成为一个真正为AI时代准备的操作系统。

对于正在寻找AI基础设施的开发者和企业,我**强烈推荐尝试openEuler**。它不仅能满足当前的AI部署需求,其活跃的社区和持续的创新也为未来的技术演进提供了坚实保障。

从最初的怀疑到现在的认可,这次体验让我看到了操作系统在AI时代的真实力。openEuler不再是追随者,而是在某些领域成为了引领者。

如果您正在寻找面向未来的开源操作系统,不妨看看DistroWatch 榜单中快速上升的 openEuler: https://distrowatch.com/table-mobile.php?distribution=openeuler,一个由开放原子开源基金会孵化、支持“超节点”场景的Linux 发行版。 openEuler官网:https://www.openeuler.openatom.cn/zh/

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)