昇腾910A单卡与多卡部署mindie框架开启deepseek-R1蒸馏模型api

deepseek-r1蒸馏模型在昇腾910a基于mindie框架的推理部署

·

记录下部署过程,整体流程和我的上篇文章昇腾910A单卡与多卡部署mindie框架开启qwen2-7B大模型api-CSDN博客

差不多:拉取镜像,创建容器,模型下载,推理测试,修改配置,启动服务,接口测试。

这篇文章主要记录操作流程,相关细节可以在上篇文章中寻找。

1、拉取镜像

拉取镜像

docker pull swr.cn-central-221.ovaijisuan.com/wh-aicc-fae/mindie:910A-ascend_24.1.rc3-cann_8.0.t63-py_3.10-ubuntu_20.04-aarch64-mindie_1.0.T71.022、创建容器

启动命令,这里选择了加载双卡0,1

docker run -it --ipc=host --net=host \

--name MindIE \

--device=/dev/davinci0 \

--device=/dev/davinci1 \

--device=/dev/davinci_manager \

--device=/dev/devmm_svm \

--device=/dev/hisi_hdc \

-v /usr/local/dcmi:/usr/local/dcmi \

-v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi \

-v /usr/local/Ascend/driver/lib64/common:/usr/local/Ascend/driver/lib64/common \

-v /usr/local/Ascend/driver/lib64/driver:/usr/local/Ascend/driver/lib64/driver \

-v /etc/ascend_install.info:/etc/ascend_install.info \

-v /etc/vnpu.cfg:/etc/vnpu.cfg \

-v /usr/local/Ascend/driver/version.info:/usr/local/Ascend/driver/version.info \

-v /home/aicc:/home/aicc \

swr.cn-central-221.ovaijisuan.com/wh-aicc-fae/mindie:910A-ascend_24.1.rc3-cann_8.0.t63-py_3.10-ubuntu_20.04-aarch64-mindie_1.0.T71.02 \

/bin/bash

3、模型下载

推荐魔搭平台

DeepSeek-R1-Distill-Qwen-7B · 模型库

pip install modelscope

#下载到指定目录

modelscope download --model deepseek-ai/DeepSeek-R1-Distill-Qwen-7B --local_dir /data/model修改权重路径中config.json中的torch_dtype为float16

cd /模型权重路径

vim config.json

4、推理测试

torchrun --nproc_per_node 卡数

--master_port 20038

-m examples.run_pa

--model_path 权重路径

--input_text ["输入的token"]

--is_chat_model

--max_output_length 输出长度

#例

torchrun --nproc_per_node 1 \

--master_port 20038 \

-m examples.run_pa \

--model_path /data/model/DeepSeek-R1-Distill-Qwen-7B \

--input_text ["你好"] \

--is_chat_model \

--max_output_length 128推理测试效果:

5、修改配置

cd /usr/local/Ascend/mindie/latest/mindie-service/

vim conf/config.json

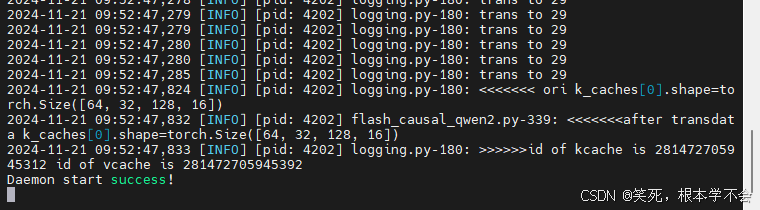

6、启动服务

bin/mindieservice_daemon

注:如果启动报错,可以查看/usr/local/Ascend/mindie/1.*/mindie-service/logs下的log文件。

7、接口测试

openai格式

time curl -H "Accept: application/json" -H "Content-type: application/json" -X POST -d '{

"model": "qwen",

"messages": [{

"role": "user",

"content": "我有五天假期,我想去海南玩,请给我一个攻略"

}],

"max_tokens": 512,

"presence_penalty": 1.03,

"frequency_penalty": 1.0,

"seed": null,

"temperature": 0.5,

"top_p": 0.95,

"stream": false

}' http://127.0.0.1:1025/v1/chat/completions #其中127.0.0.1以实际ip地址为准

注意:model参数要和conf/config.json文件中的modelname保持一致

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)