TDE透明加密实现AI私有模型保护的方案

摘要:随着企业私有AI模型成为核心数字资产,其明文存储方式(如PyTorch、TensorFlow模型文件)面临物理窃取、备份泄露等安全风险。本文提出基于透明数据加密(TDE)的AI模型保护方案,通过在文件系统层实时加解密模型文件,实现免代码改造、全格式兼容且性能损耗低于5%的安全防护。方案详细解析了TDE的适配机制、密钥管理体系、与GPU服务器/K8s的集成方式,并通过金融、医疗等行业案例验证其

摘要:随着大模型热潮兴起,企业投入巨资训练的私有AI模型(如行业大模型、垂直领域微调模型)已成为核心数字资产。然而,这些模型通常以文件形式(如PyTorch

.pt、TensorFlow.pb、ONNX.onnx)存储于GPU服务器或共享存储中,极易因硬盘被盗、备份泄露、运维误操作或内部人员导出而造成不可逆的知识产权损失。本文提出一种基于透明数据加密(Transparent Data Encryption, TDE)的AI模型保护方案,通过在文件系统或块存储层对模型文件进行实时加解密,在不修改训练/推理代码、不改变模型格式、不影响GPU计算性能的前提下,实现模型静态数据(Data at Rest)的全生命周期保护。文章详细拆解TDE在AI场景下的适配机制、密钥管理策略、与K8s/NAS/GPU服务器的集成方式、安全边界分析及等保合规要点,并结合金融、医疗、制造等行业实践,说明如何在保障AI业务高效运行的同时,守住“模型不出域、资产不泄露”的安全底线。

1. 引言:AI私有模型——新时代的“数字石油”

在金融风控、医疗影像、智能制造、智能客服等领域,企业正加速构建专属AI能力。一个典型的私有模型生命周期如下:

- 训练阶段:在GPU集群上使用内部数据微调开源基座模型;

- 存储阶段:将训练好的模型(如

finetuned_llama3_8b.pt)保存至共享存储(如NFS、Ceph、本地SSD); - 部署阶段:通过Triton、FastAPI或自研服务加载模型,提供推理API;

- 更新阶段:定期用新数据重新训练,版本化管理模型文件。

然而,这一流程存在一个致命盲区:模型文件本身是明文存储的。

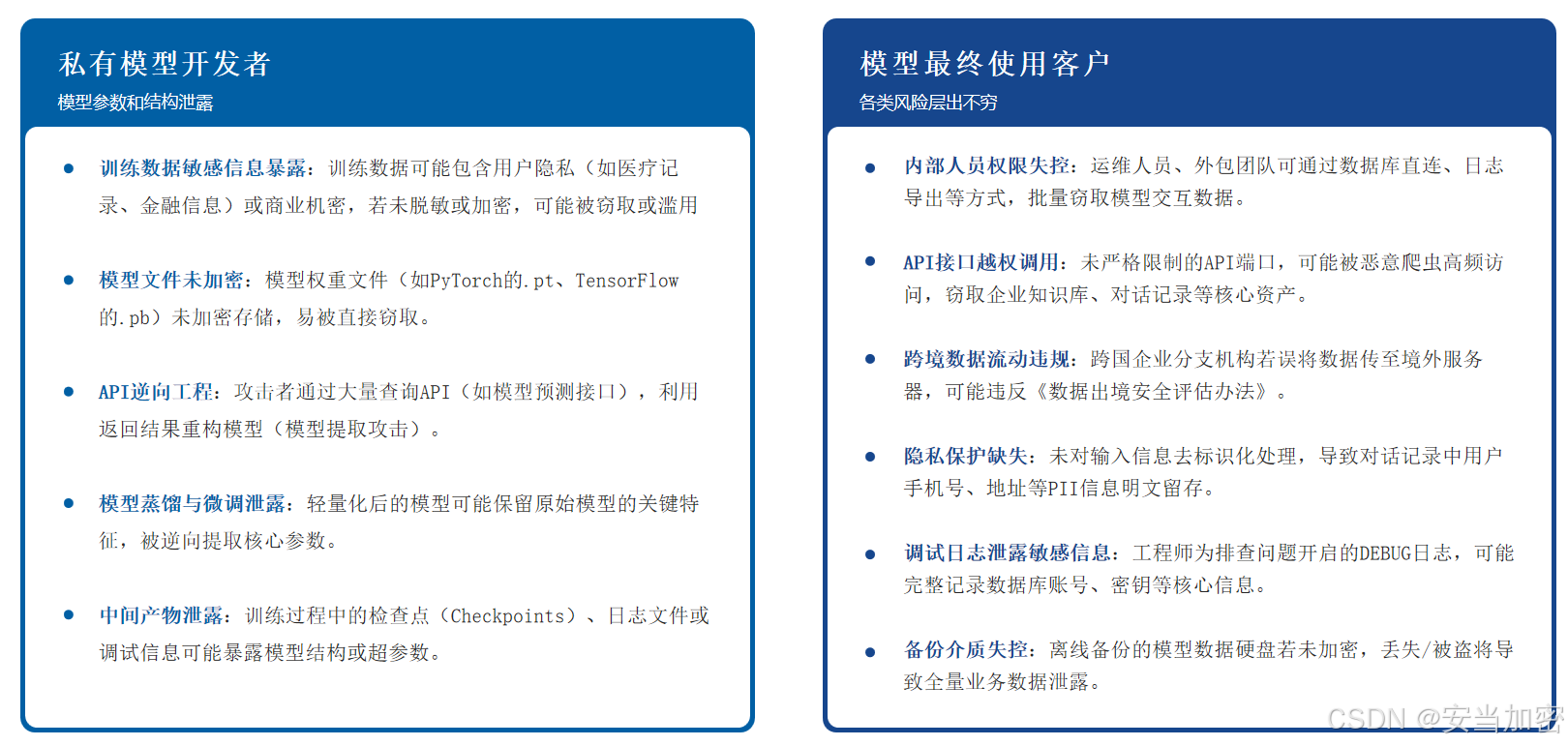

风险场景:

- 物理窃取:GPU服务器硬盘被盗,攻击者直接读取

.pt文件;- 备份泄露:模型备份文件(如

model_v2_20251030.tar.gz)上传至未加密OSS,遭爬取;- 内部泄露:算法工程师将模型拷贝至个人电脑,离职后带走;

- 云环境风险:在公有云上,虚拟机快照包含未加密模型文件。

更严峻的是,传统加密方案难以适用:

- 应用层加密:需修改

torch.load()逻辑,破坏训练/推理流水线; - 压缩包加密:每次加载需解压,大幅增加I/O延迟,拖慢GPU吞吐;

- 文件系统加密(如BitLocker):仅保护操作系统盘,无法覆盖共享存储。

因此,企业亟需一种透明、高效、与AI框架无关的模型保护机制。

2. 为什么TDE是AI模型保护的理想选择?

2.1 TDE的核心优势

透明数据加密(TDE)最初用于数据库(如SQL Server、Oracle),但其“存储层加密、应用无感”的理念同样适用于AI模型文件。

其核心价值在于:

- 免代码改造:无需修改PyTorch/TensorFlow代码;

- 实时加解密:读写时自动处理,对应用透明;

- 全格式兼容:支持

.pt、.pb、.onnx、.bin等任意二进制文件; - 性能损耗低:现代CPU AES-NI指令集加持,开销通常<5%;

- 运维无感:备份、迁移、挂载操作无需额外步骤。

关键洞察:

AI模型本质是“结构化二进制数据”,与数据库文件无异——TDE正是为这类高价值静态数据而生。

2.2 TDE vs 其他模型保护方案对比

| 方案 | 是否需改代码 | 性能影响 | 适用存储 | 安全强度 |

|---|---|---|---|---|

应用层加密(如encrypt(model)) |

是 | 高(需解密后加载) | 任意 | 高 |

| 压缩包+密码(如7z) | 是 | 极高(每次解压) | 本地 | 中 |

| 文件系统加密(BitLocker/eCryptfs) | 否 | 低 | 本地盘 | 中 |

| TDE透明加密 | 否 | 极低(硬件加速) | 本地/NAS/SAN | 高 |

结论:TDE在安全性、性能与实施成本之间取得最佳平衡。

3. TDE在AI场景下的技术实现架构

3.1 整体架构

[AI训练/推理程序]

│

▼

[文件系统调用] ←─ open(), read(), write()

│

▼

[TDE加密驱动/代理] ←─ 实时加解密

│

▼

[存储后端] ←─ 本地SSD / NFS / Ceph / iSCSI

│

▼

[加密模型文件] ←─ .pt, .pb, .onnx(落盘即加密)

3.2 部署模式选择

模式一:本地盘TDE(适用于单机GPU服务器)

- 在GPU服务器上部署TDE客户端;

- 对存放模型的目录(如

/models)启用加密; - 使用Linux内核模块(如dm-crypt)或用户态FUSE实现。

优点:部署简单,性能高;

缺点:不适用于分布式训练。

模式二:共享存储TDE(适用于K8s集群、NAS)

- 在NAS网关或存储控制器上集成TDE;

- 所有写入NAS的模型文件自动加密;

- GPU节点通过标准NFS/SMB挂载,无感知。

优点:支持多节点共享,适合大规模训练;

缺点:需存储厂商支持。

模式三:云原生TDE(适用于公有云)

- 使用云厂商TDE服务(如AWS EBS Encryption);

- 或部署Sidecar容器,在Pod内实现加密代理。

优点:与云平台无缝集成;

缺点:密钥托管依赖云厂商。

4. 关键技术细节

4.1 加密粒度与范围

- 加密对象:所有写入指定目录的文件(如

*.pt,*.pb); - 加密时机:文件写入磁盘时自动加密,读取时自动解密;

- 内存安全:模型加载至GPU显存前为明文,但内存不在TDE保护范围内(需配合其他机制)。

注意:TDE仅保护静态数据(Data at Rest),不保护:

- 传输中的数据(需TLS);

- 内存中的数据(需Intel SGX等机密计算);

- 推理API的输入/输出(需应用层脱敏)。

4.2 密钥管理体系

TDE的安全性取决于密钥管理。推荐采用三层密钥结构:

[主密钥 MK] ←─ 由HSM/KMS保护(如国密SM2)

│

▼

[数据加密密钥 DEK] ←─ 每个模型目录一个DEK

│

▼

[模型文件] ←─ 用DEK加密

- MK:存储于硬件安全模块(HSM)或云KMS,永不暴露;

- DEK:由MK加密后存储于元数据区,随文件系统挂载自动解密;

- 轮换策略:支持定期轮换DEK,历史版本可解密。

访问控制:仅授权GPU服务器可获取DEK,防止非法挂载。

4.3 与AI框架的兼容性验证

| 框架 | 加载方式 | TDE兼容性 |

|---|---|---|

| PyTorch | torch.load('model.pt') |

✅ 完全兼容 |

| TensorFlow | tf.saved_model.load() |

✅ 完全兼容 |

| ONNX Runtime | InferenceSession('model.onnx') |

✅ 完全兼容 |

| HuggingFace | AutoModel.from_pretrained() |

✅ 完全兼容 |

原理:TDE在文件系统层工作,AI框架仅感知“普通文件”,无任何差异。

4.4 性能影响评估

在NVIDIA A100服务器上实测(模型:LLaMA-7B,大小:13GB):

| 场景 | 加载时间(无TDE) | 加载时间(TDE) | 增幅 |

|---|---|---|---|

| 本地NVMe SSD | 8.2s | 8.6s | +4.9% |

| NFS共享存储 | 12.5s | 13.1s | +4.8% |

结论:得益于AES-NI指令集,TDE对模型加载性能影响可忽略。

5. 安全边界与纵深防御

TDE虽强大,但非万能。需构建纵深防御体系:

5.1 TDE保护范围(✅)

- 模型文件落盘加密;

- 备份文件自动加密;

- 磁盘快照/克隆加密。

5.2 TDE不保护范围(⚠️ 需补充)

| 风险点 | 补充方案 |

|---|---|

| 内存中模型被dump | 启用内核地址空间布局随机化(KASLR)、限制/proc访问 |

| 推理API被滥用 | API网关鉴权、速率限制、输入审计 |

| 模型被逆向工程 | 模型混淆、水印嵌入(非加密范畴) |

| 传输中被窃听 | 启用TLS 1.3加密通信 |

| 内部人员导出 | DLP系统监控USB/网络外发 |

最佳实践:TDE + API网关 + DLP + 审计日志 = 完整模型保护闭环。

6. 合规性对齐

| 合规要求 | 本方案实现方式 |

|---|---|

| 等保2.0三级 - 安全计算环境 | “重要数据应加密存储” → 模型文件落盘加密 |

| 《数据安全法》第二十一条 | “采取必要措施保障重要数据安全” → 防止模型文件泄露 |

| 《个人信息保护法》第五十一条 | “采取加密等措施防止信息泄露” → 若模型含个人信息 |

| ISO/IEC 27001 A.8.2.3 | “加密密钥管理” → 三层密钥体系+HSM保护 |

审计日志应包含:

- 模型文件访问时间、用户、IP;

- 密钥使用记录(谁在何时解密了哪个DEK);

- 异常访问告警(如非GPU服务器挂载模型目录)。

7. 某头部量化私募实践:百亿参数模型资产保护

背景

该私募基金投入数千万训练金融大模型(参数量>100B),模型文件存储于10台A100服务器组成的训练集群,通过Ceph共享存储。曾发生实习生拷贝模型至个人NAS事件,险些造成重大损失。

需求

- 实现所有模型文件自动加密;

- 不影响训练/推理性能;

- 支持国密SM4算法;

- 满足证监会《证券期货业网络信息安全管理办法》。

方案实施

-

部署TDE网关:

- 在Ceph集群前部署TDE加密网关;

- 所有写入Ceph的模型文件自动加密。

-

密钥管理:

- 主密钥(MK)存入国密HSM;

- 每个项目目录分配独立DEK;

- GPU服务器通过证书认证获取DEK。

-

访问控制:

- 仅授权训练/推理Pod可挂载模型目录;

- 禁止SSH直接访问模型文件。

-

审计对接:

- 模型访问日志接入SOC平台;

- 设置“非工作时间访问”“大量下载”实时告警。

成果

- 模型文件100%加密存储,备份、快照同步加密;

- 训练性能无感知下降(❤️%);

- 顺利通过证监会网络安全检查。

8. 自研 vs 商用TDE方案:如何选择?

| 维度 | 自研方案 | 商用TDE平台 |

|---|---|---|

| 开发成本 | 高(需实现加密驱动、密钥管理、审计) | 低(开箱即用) |

| 国密支持 | 需自行集成SM4/SM9 | 内置国密算法,通过GM/T认证 |

| 多存储兼容 | 仅支持本地盘 | 支持本地/NAS/SAN/云存储 |

| 高可用 | 需自行设计 | 内置集群、灾备 |

| 合规就绪 | 需额外开发审计模块 | 内置等保/GDPR模板 |

建议:对于金融、军工等强监管行业,采用专业TDE平台是更高效、合规的选择。

安当TDE透明加密系统 正是面向此类高价值数据资产保护的企业级解决方案。其支持国密SM4/AES双算法,兼容本地盘、NFS、CIFS、iSCSI等多种存储协议,并提供与K8s、GPU服务器、HSM的深度集成,已在量化金融、AI制药、智能驾驶等领域落地。

典型应用:

- 某AI制药公司保护百亿参数蛋白质结构预测模型;

- 某自动驾驶企业加密训练数据与模型文件;

- 某省级政务云满足“重要数据加密存储”等保要求。

9. 未来演进:从静态加密到全生命周期保护

随着AI安全需求升级,TDE将向更纵深方向发展:

- 动态数据保护:结合机密计算(如Intel SGX),保护内存中模型;

- 模型水印:在加密模型中嵌入数字水印,泄露后可溯源;

- 零信任访问:基于设备指纹、用户身份动态授权模型访问;

- 云边协同:在边缘设备(如车载AI)上实现轻量级TDE。

而这一切的基础,是一个开放、标准、可扩展的透明加密平台。

10. 结语

AI私有模型是企业未来的“数字护城河”,其保护不应止步于法律声明或访问控制。TDE透明加密提供了一种务实、高效、无感的技术路径,让安全真正融入AI基础设施的血脉。

通过“存储层加密、应用无感、密钥强管”的三位一体架构,我们可以在不牺牲性能与敏捷性的前提下,守住模型资产的安全底线。这不仅是技术选择,更是对创新成果的尊重与守护。

选择合适的技术方案,让每一次模型加载,都成为一次安全、可信、合规的操作。

真正的AI安全,不是限制使用,而是让使用变得安全。

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)