Deep-Reinforcement-Learning-Algorithms-with-PyTorch部署指南:生产环境最佳实践 [特殊字符]

想要将强化学习算法从实验室推向生产环境?Deep-Reinforcement-Learning-Algorithms-with-PyTorch项目提供了完整的PyTorch实现,让你能够快速部署高质量的强化学习解决方案。本文为你揭秘**强化学习算法部署**的关键步骤和最佳实践!## 📋 环境准备与依赖管理成功的部署始于稳定的环境配置。项目提供了完整的依赖清单:**核心依赖安装**:

PyTorch深度强化学习算法部署指南:生产环境最佳实践

深度强化学习算法在现代人工智能应用中扮演着重要角色,而PyTorch作为深度学习框架的佼佼者,为这些算法的实现和部署提供了强大支持。本指南将带您了解如何在生产环境中高效部署PyTorch深度强化学习算法,确保稳定性和性能优化。

🚀 环境配置与依赖管理

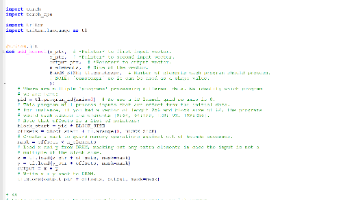

首先需要配置合适的开发环境。项目依赖主要包括PyTorch、numpy、gym等核心库:

- PyTorch 0.4.1:深度学习框架核心

- OpenAI Gym 0.10.9:强化学习环境标准

- NumPy 1.15.2:数值计算基础

- Matplotlib 3.0.0:结果可视化工具

关键步骤:

- 创建conda虚拟环境:

conda create --name drl_pytorch python=3.7 - 激活环境:

conda activate drl_pytorch - 安装依赖:

pip install -r requirements.txt

🔧 算法选择与性能优化

项目中实现了多种深度强化学习算法,包括DQN系列、Actor-Critic方法、分层强化学习等。选择合适的算法对于生产环境至关重要:

经典算法对比:

- DQN系列:适合离散动作空间任务

- DDPG/TD3:专为连续控制任务设计

- PPO/SAC:在复杂环境中表现稳定

📊 模型训练与监控

在生产环境中部署强化学习算法时,监控训练过程是必不可少的环节:

训练配置管理

在utilities/data_structures/Config.py中定义了完整的训练参数配置,包括学习率、批次大小、经验回放缓冲区大小等。

性能可视化

使用utilities/Tensorboard.py可以实时监控训练进度和算法性能。

🎯 实际部署策略

1. 渐进式部署

建议先在测试环境中验证算法效果,然后逐步在生产环境中部署。可以参考results/Cart_Pole.py中的实现模式。

2. 模型版本控制

- 定期保存训练好的模型权重

- 建立模型性能评估机制

- 实现A/B测试框架

🔍 关键模块详解

智能体架构

项目采用模块化设计,不同类型的智能体分别位于:

- agents/DQN_agents/:DQN系列算法

- agents/actor_critic_agents/:Actor-Critic方法

- agents/hierarchical_agents/:分层强化学习算法

环境封装

自定义环境实现位于environments/目录,包括Bit Flipping、Four Rooms等经典环境。

⚡ 性能调优技巧

经验回放优化

- 使用utilities/data_structures/Prioritised_Replay_Buffer.py实现优先经验回放

- 调整回放缓冲区大小和采样策略

探索策略配置

- Epsilon-Greedy策略:适合离散动作空间

- OU Noise策略:专为连续控制任务设计

🛡️ 生产环境注意事项

稳定性保障

- 实现模型检查点和恢复机制

- 配置适当的超参数搜索空间

- 建立异常处理机制

资源管理

- GPU内存优化配置

- 分布式训练支持

- 模型推理加速

📈 监控与日志管理

建议在生产环境中建立完善的监控体系:

- 训练过程监控:实时跟踪奖励曲线和损失函数

- 系统资源监控:CPU、GPU、内存使用情况

- 性能指标记录:成功率、收敛速度等关键指标

🎉 总结与展望

PyTorch深度强化学习算法在生产环境中的成功部署需要综合考虑算法选择、性能优化、监控管理等多个方面。通过本指南提供的最佳实践,您可以更高效地将强化学习算法应用于实际业务场景。

记住,深度强化学习是一个快速发展的领域,持续关注最新研究进展和技术优化是保持竞争力的关键。

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

项目地址: https://gitcode.com/gh_mirrors/de/Deep-Reinforcement-Learning-Algorithms-with-PyTorch

项目地址: https://gitcode.com/gh_mirrors/de/Deep-Reinforcement-Learning-Algorithms-with-PyTorch

所有评论(0)