10分钟上手:autocannon与Oracle Cloud集成的OCI性能测试实战指南

你是否曾在Oracle Cloud Infrastructure(OCI)上部署应用后,面临这些困惑:生产环境的真实负载能力到底如何?如何验证OCI计算实例的性能是否匹配业务需求?传统测试工具要么配置复杂,要么无法模拟真实流量模式。本文将通过autocannon这一轻量级HTTP基准测试工具,带你快速掌握OCI环境下的性能测试方法论,从环境搭建到报告分析全程实操,让你10分钟内获得可量化的性能数据

10分钟上手:autocannon与Oracle Cloud集成的OCI性能测试实战指南

你是否曾在Oracle Cloud Infrastructure(OCI)上部署应用后,面临这些困惑:生产环境的真实负载能力到底如何?如何验证OCI计算实例的性能是否匹配业务需求?传统测试工具要么配置复杂,要么无法模拟真实流量模式。本文将通过autocannon这一轻量级HTTP基准测试工具,带你快速掌握OCI环境下的性能测试方法论,从环境搭建到报告分析全程实操,让你10分钟内获得可量化的性能数据。

读完本文你将获得:

- 一套在OCI中快速部署autocannon的标准化流程

- 针对计算实例、负载均衡和API网关的三类测试模板

- 基于真实业务场景的性能指标解读方法

- 分布式测试与结果聚合的高级技巧

环境准备:OCI与autocannon的无缝衔接

autocannon作为Node.js编写的HTTP/1.1基准测试工具,具备高并发、低资源占用的特性,特别适合在OCI的容器化环境中运行。其核心优势在于支持HTTP流水线(HTTP pipelining)和HTTPS协议,能产生比传统工具更高的测试负载,同时提供精细的延迟分布统计。

基础安装与验证

在OCI Compute实例中,通过npm快速安装autocannon:

npm i autocannon -g

验证安装是否成功:

autocannon --version

对于容器化部署场景,项目提供了预配置的Docker环境。查看docker-compose.yml文件,其中定义了autocannon与目标服务的联动测试架构:

version: "3"

services:

autocannon:

image: node:18-alpine

volumes:

- ./:/app

working_dir: /app

depends_on:

- target-service

command: npx autocannon --connection 100 --duration 30 http://target-service:3000

target-service:

image: node:18-alpine

volumes:

- ./server.js:/app/server.js

command: node /app/server.js

核心测试场景与OCI资源适配

1. 计算实例性能基线测试

针对OCI Compute实例(如VM.Standard.E4.Flex),使用基础命令建立性能基准:

autocannon -c 50 -d 60 -p 10 https://your-instance-ip:8080/api/health

参数说明:

-c 50:并发连接数50-d 60:测试持续60秒-p 10:每个连接的HTTP流水线请求数10

该命令将生成类似以下的统计结果:

┌─────────┬──────┬──────┬───────┬──────┬─────────┬─────────┬──────────┐

│ Stat │ 2.5% │ 50% │ 97.5% │ 99% │ Avg │ Stdev │ Max │

├─────────┼──────┼──────┼───────┼──────┼─────────┼─────────┼──────────┤

│ Latency │ 0 ms │ 0 ms │ 0 ms │ 1 ms │ 0.02 ms │ 0.16 ms │ 16.45 ms │

└─────────┴──────┴──────┴───────┴──────┴─────────┴─────────┴──────────┘

关键指标解读:

- 97.5%延迟:反映大多数用户的真实体验,OCI实例通常应控制在10ms以内

- Req/Sec:每秒请求数,与实例OCPU数量正相关

- Bytes/Sec:带宽消耗,需与OCI虚拟网络配置匹配

2. 负载均衡器(LBaaS)压力测试

OCI Load Balancing服务需要模拟分布式流量,可使用autocannon的多URL测试能力。创建测试脚本bench-multi-url.js:

const autocannon = require('autocannon')

const urls = [

'https://lb-oci-example.com/service-a',

'https://lb-oci-example.com/service-b',

'https://lb-oci-example.com/service-c'

]

autocannon({

urls,

connections: 150,

duration: 120,

overallRate: 1000

}, console.log)

执行测试:

node samples/bench-multi-url.js

此方案通过设置overallRate: 1000控制总请求速率,避免瞬间流量冲击导致LB健康检查失败。测试结果可用于验证LB的流量分发策略和后端服务器的弹性伸缩阈值。

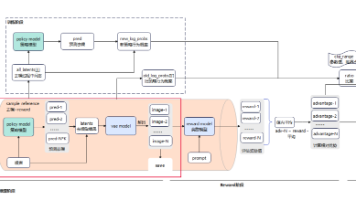

3. Kubernetes集群中的分布式测试

对于OCI Container Engine for Kubernetes(OKE)环境,项目提供了Kubernetes部署模板k8s/autocannon-statefulset.yaml,核心配置:

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: autocannon-benchmark

spec:

replicas: 3

template:

spec:

containers:

- name: autocannon

image: node:18-alpine

command: ["npx", "autocannon", "--connection", "100", "--duration", "30", "http://target-service:3000"]

resources:

limits:

cpu: "1"

memory: "1Gi"

通过调整replicas数量实现测试流量的线性扩展,每个副本独立运行测试并生成结果。这种架构特别适合模拟全球分布式用户对部署在OKE中的微服务的访问压力。

高级技巧:精准控制与结果分析

请求速率精确控制

为避免测试流量对OCI服务造成过载,autocannon提供两种速率控制模式:

--connectionRate:单连接请求速率限制--overallRate:全局请求速率限制

例如,模拟每秒500请求的稳定流量:

autocannon --overallRate 500 --duration 180 https://api-gateway.oci.example.com

当服务器响应延迟增加时,autocannon会自动补偿请求发送时间,解决"协调遗漏"(Coordinated Omission)问题,确保延迟统计的准确性。这一机制通过lib/runTracker.js实现,是相比wrk等工具的重要改进。

结果聚合与可视化

对于多实例分布式测试,使用autocannon的API聚合结果:

const { aggregateResult } = require('autocannon')

// 聚合多个测试结果

const aggregated = aggregateResult([result1, result2, result3], {

url: 'https://target-service.oci.example.com',

connections: 300,

duration: 60

})

console.log(aggregated)

核心聚合逻辑在lib/aggregateResult.js中实现,支持将分散的测试数据合并为统一报告,便于在OCI监控面板中展示关键指标趋势。

最佳实践与避坑指南

资源配置建议

| OCI服务类型 | 推荐autocannon配置 | 测试注意事项 |

|---|---|---|

| VM.Standard.E4.Flex | -c 100 -p 5 | 启用CPU性能模式 |

| Load Balancer | --overallRate 2000 | 逐步提升流量,观察健康检查状态 |

| API Gateway | -d 300 --bailout 100 | 延长测试时间,设置错误容忍阈值 |

| Object Storage | -m PUT --body /data/testfile | 使用预签名URL,避免认证瓶颈 |

常见问题解决方案

- 测试结果波动大:启用OCI实例的"高性能模式",关闭CPU节流

- 连接数受限时:使用

--workers N参数启用多线程模式,N建议等于CPU核心数 - SSL握手延迟高:预先生成连接池,通过

--warmup [ -c 10 -d 5 ]配置预热阶段 - 需要持久化测试报告:结合OCI Object Storage,修改printResult.js将结果输出到对象存储

总结与进阶路线

通过本文介绍的方法,你已掌握在OCI环境中使用autocannon进行性能测试的核心技能。从单实例基准测试到Kubernetes分布式压测,autocannon提供了轻量级但功能完备的解决方案,其模块化设计lib/允许根据OCI服务特性进行灵活定制。

进阶学习路径:

- 深入理解request-context.js中的上下文管理,模拟用户会话

- 使用HAR文件导入真实用户流量,实现场景化测试

- 结合OCI Monitoring服务,建立性能指标的长期监控与告警

立即行动:使用以下命令克隆项目,开始你的OCI性能探索之旅:

git clone https://gitcode.com/gh_mirrors/au/autocannon

cd autocannon

npm install

后续我们将推出"OCI无服务器架构(FAAS)的性能优化"专题,探讨如何使用autocannon测试Oracle Functions的冷启动性能与并发处理能力。保持关注,持续优化你的云基础设施性能!

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

项目地址: https://gitcode.com/gh_mirrors/au/autocannon

项目地址: https://gitcode.com/gh_mirrors/au/autocannon

所有评论(0)