用autocannon测试实时分析系统:Kafka Streams性能评估

你是否在部署Kafka Streams实时分析系统时遇到过这些问题:生产环境中数据峰值导致流处理延迟飙升?用户投诉实时看板加载缓慢但无法定位瓶颈?本文将展示如何使用autocannon这款高性能HTTP基准测试工具,通过模拟真实流量模式来评估Kafka Streams应用的吞吐量、延迟特性和资源利用率,为系统调优提供数据支持。读完本文你将掌握:构建贴近生产的测试场景、关键指标采集方法、性能瓶颈定位

用autocannon测试实时分析系统:Kafka Streams性能评估

你是否在部署Kafka Streams实时分析系统时遇到过这些问题:生产环境中数据峰值导致流处理延迟飙升?用户投诉实时看板加载缓慢但无法定位瓶颈?本文将展示如何使用autocannon这款高性能HTTP基准测试工具,通过模拟真实流量模式来评估Kafka Streams应用的吞吐量、延迟特性和资源利用率,为系统调优提供数据支持。读完本文你将掌握:构建贴近生产的测试场景、关键指标采集方法、性能瓶颈定位技巧,以及生成可复现的评估报告。

测试环境准备

工具安装与基本配置

autocannon是基于Node.js开发的HTTP/1.1基准测试工具(项目描述),相比传统工具具有更高的并发性能和更灵活的测试配置。通过以下命令安装:

npm i autocannon -g

验证安装成功后,可通过autocannon -h查看完整参数列表(帮助文档)。核心测试参数包括:

-c/--connections: 并发连接数-d/--duration: 测试持续时间(秒)-r/--connectionRate: 每秒请求率控制-w/--workers: 启用多线程测试模式

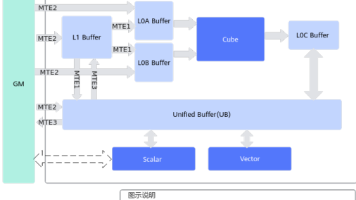

测试目标系统架构

本文以典型Kafka Streams实时分析系统为测试对象,其架构包含:

- 数据接入层:HTTP API接收生产数据并写入Kafka主题

- 流处理层:Kafka Streams拓扑进行窗口聚合计算

- 查询服务层:提供聚合结果的REST查询接口

测试重点关注查询服务层的性能表现,该层直接影响用户体验。测试前需确保Kafka集群、Streams应用和查询服务已正确部署并预热完成。

构建真实测试场景

流量模式设计

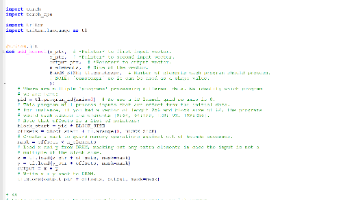

实时分析系统的查询请求通常具有以下特征:高峰期每秒数百次聚合查询、查询条件包含复杂时间窗口、结果集大小动态变化。使用autocannon的多请求序列功能(示例代码)模拟这种场景:

autocannon({

url: 'http://streams-query-service:8080',

connections: 50, // 模拟50个并发连接

duration: 300, // 持续5分钟测试

overallRate: 200, // 控制总请求率200 QPS

requests: [

{ // 最近5分钟销售额聚合查询

method: 'GET',

path: '/sales/agg?window=5m&groupBy=product',

setupRequest: (req, context) => {

// 动态调整时间参数模拟实时查询特征

const now = Date.now()

req.path = `/sales/agg?window=5m&end=${now}`

return req

}

},

{ // 产品类别实时排名查询

method: 'GET',

path: '/products/ranking?top=10'

}

]

}, (err, result) => { /* 结果处理 */ })

动态上下文管理

通过autocannon的上下文机制(API文档)维护跨请求状态,模拟用户会话中的关联查询。例如在电商场景中,先查询商品详情再查询库存状态:

{

requests: [

{

method: 'GET',

path: '/products/[<id>]', // 使用ID替换功能([<id>])

onResponse: (status, body, context) => {

if (status === 200) {

context.productId = JSON.parse(body).id // 提取商品ID到上下文

}

}

},

{

setupRequest: (req, context) => {

// 使用前一个请求获取的商品ID

req.path = `/inventory?productId=${context.productId}`

return req

}

}

],

idReplacement: true // 启用ID随机生成

}

关键性能指标采集

核心测试指标定义

使用autocannon的默认输出表格(示例)记录以下关键指标:

| 指标类别 | 关注重点 | 评估标准 |

|---|---|---|

| 吞吐量 | Req/Sec (1%、50%、97.5%分位数) | 稳定达到设计QPS(如200 req/sec) |

| 延迟 | Latency (50%、97.5%、99%分位数) | 97.5%延迟<200ms |

| 错误率 | 非2xx响应占比 | 错误率<0.1% |

| 资源利用率 | CPU/内存/网络IO | Kafka Streams应用CPU<80% |

实时监控与数据记录

通过autocannon的跟踪功能(示例代码)实时监控测试进度,并结合系统监控工具采集资源使用情况:

const instance = autocannon(opts)

autocannon.track(instance, { renderLatencyTable: true }) // 启用详细延迟数据

// 每秒钟记录一次系统指标

setInterval(() => {

recordMetrics({

timestamp: Date.now(),

rps: instance.stats.currentRps,

latency: instance.stats.latency,

kafkaConsumerLag: getKafkaConsumerLag(), // 自定义Kafka延迟采集

jvmMemory: getJvmMemoryUsage() // Java应用内存使用

})

}, 1000)

测试结束后,autocannon会生成完整的统计报告,典型输出格式如下:

┌─────────┬──────┬──────┬───────┬──────┬─────────┬─────────┬──────────┐

│ Stat │ 2.5% │ 50% │ 97.5% │ 99% │ Avg │ Stdev │ Max │

├─────────┼──────┼──────┼───────┼──────┼─────────┼─────────┼──────────┤

│ Latency │ 45ms │ 89ms │ 156ms │ 189ms│ 92.3ms │ 32.1ms │ 247ms │

└─────────┴──────┴──────┴───────┴──────┴─────────┴─────────┴──────────┘

┌───────────┬─────────┬─────────┬─────────┬─────────┬─────────┬─────────┐

│ Stat │ 1% │ 2.5% │ 50% │ 97.5% │ Avg │ Stdev │

├───────────┼─────────┼─────────┼─────────┼─────────┼─────────┼─────────┤

│ Req/Sec │ 185 │ 192 │ 201 │ 205 │ 198.7 │ 5.3 │

└───────────┴─────────┴─────────┴─────────┴─────────┴─────────┴─────────┘

性能瓶颈分析方法

基于测试结果的调优方向

通过autocannon的测试数据,结合Kafka Streams应用特征,可以定位以下常见瓶颈:

-

处理节点资源不足:当97.5%延迟随并发连接数增加呈线性增长,且CPU使用率持续>80%,表明流处理任务需要增加并行度。可通过调整

num.stream.threads参数优化。 -

状态存储优化:若聚合查询延迟波动大,可能是RocksDB状态存储出现瓶颈。建议测试不同的状态存储配置(调优指南)。

-

网络带宽限制:Bytes/Sec指标接近网卡理论上限时,考虑启用压缩或增加网络带宽。autocannon的Bytes/Sec统计可帮助确认这一点。

对比测试与优化验证

使用autocannon的--title参数标记不同测试场景,通过对比结果验证优化效果:

# 优化前基准测试

autocannon -c 50 -d 300 -r 200 --title "before-optimization" http://target-url

# 增加Kafka Streams线程数后测试

autocannon -c 50 -d 300 -r 200 --title "after-thread-tuning" http://target-url

通过对比两次测试的 latency P97.5 和 Req/Sec 指标,量化优化效果。建议使用autocannon的JSON输出格式(参数说明)将结果导入Grafana等工具进行可视化分析。

测试报告与持续监控

生成可复现的测试报告

结合autocannon的测试结果和系统监控数据,生成包含以下内容的性能评估报告:

- 测试环境配置(硬件、软件版本、Kafka集群规模)

- 测试场景详情(流量模式、并发用户数、数据分布)

- 关键指标对比(吞吐量、延迟、错误率)

- 性能瓶颈分析及优化建议

- 回归测试基准值

集成到CI/CD流程

将autocannon测试集成到持续集成流程中,通过以下步骤实现性能 regression 检测:

- 在测试环境部署Kafka Streams应用

- 运行autocannon测试并记录基准指标

- 对比当前结果与历史基准,超过阈值则阻断部署

示例CI配置片段:

# .github/workflows/performance-test.yml

jobs:

performance:

runs-on: test-server

steps:

- name: Run autocannon test

run: autocannon -c 50 -d 120 --json http://streams-app > results.json

- name: Check latency threshold

run: node scripts/check-latency.js results.json # 自定义阈值检查脚本

总结与最佳实践

本文介绍了使用autocannon评估Kafka Streams实时分析系统性能的完整流程,包括测试场景构建、指标采集、瓶颈分析和持续监控。关键建议:

- 始终使用接近生产的流量模式进行测试,autocannon的多请求序列和上下文管理功能对此至关重要

- 关注97.5%和99%分位的延迟指标,它们比平均值更能反映用户体验

- 通过对比测试验证调优效果,每次只改变一个变量

- 将性能测试自动化,作为发布流程的一部分

autocannon作为一款高性能的HTTP基准测试工具,不仅适用于Kafka Streams,也可用于任何HTTP服务的性能评估。其灵活的API和丰富的配置选项,使其能够模拟各种复杂的真实场景。通过本文介绍的方法,你可以构建一套科学的性能评估体系,为实时分析系统的稳定运行提供保障。

点赞+收藏本文,关注后续《Kafka Streams状态存储深度优化》系列文章,深入探讨流处理性能调优的高级技巧。

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

项目地址: https://gitcode.com/gh_mirrors/au/autocannon

项目地址: https://gitcode.com/gh_mirrors/au/autocannon

所有评论(0)