docker-stacks与GPU加速:深度学习环境配置指南

在深度学习项目中,配置GPU加速环境往往耗费大量时间。本文将通过docker-stacks项目提供的预配置Docker镜像,帮助你在10分钟内搭建起支持GPU的Jupyter开发环境,无需手动安装CUDA、cuDNN等复杂依赖。## 环境准备与基础镜像选择docker-stacks提供了多个预构建的GPU加速镜像,覆盖主流深度学习框架:- **PyTorch环境**:[images/p...

终极GPU加速指南:3步配置docker-stacks深度学习环境

想要快速搭建支持GPU加速的深度学习环境?docker-stacks项目为您提供了完整的解决方案!这个开源项目包含了一系列即开即用的Docker镜像,预装了Jupyter应用和深度学习框架,让您能够专注于模型开发而非环境配置。😊

🚀 为什么选择docker-stacks进行深度学习?

docker-stacks项目专门为数据科学和机器学习工作流设计,每个镜像都经过精心配置,确保环境的稳定性和一致性。对于深度学习开发者来说,这意味着:

- 预装主流框架:TensorFlow、PyTorch、Spark等框架一应俱全

- GPU加速支持:原生支持CUDA和NVIDIA GPU加速

- 即开即用:无需繁琐的环境配置,直接运行即可开始开发

💻 快速开始:GPU环境配置步骤

第一步:选择适合的镜像

docker-stacks提供了多个专门针对深度学习的镜像:

- tensorflow-notebook - 专为TensorFlow优化的环境

- pytorch-notebook - 完整的PyTorch开发套件

- datascience-notebook - 综合性数据科学平台

第二步:配置GPU支持

确保您的系统已安装NVIDIA驱动和Docker,然后使用以下命令启动支持GPU的容器:

docker run --gpus all -p 8888:8888 jupyter/tensorflow-notebook

第三步:验证GPU加速

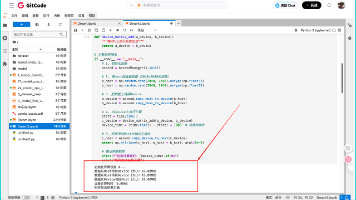

在Jupyter Notebook中运行以下代码验证GPU是否可用:

import tensorflow as tf

print("GPU可用:", tf.test.is_gpu_available())

🔧 高级配置技巧

自定义镜像构建

如果您需要特定的包或配置,可以基于现有镜像进行自定义。参考base-notebook的结构,创建自己的Dockerfile:

FROM jupyter/base-notebook

# 安装额外的深度学习包

RUN pip install torchvision transformers

持久化数据存储

使用Docker卷来保存您的模型和数据:

docker run -v /path/to/your/data:/home/jovyan/work jupyter/tensorflow-notebook

🎯 最佳实践建议

- 镜像选择策略:根据项目需求选择合适的镜像,避免过度安装

- 资源管理:合理分配GPU内存,避免资源冲突

- 版本控制:定期更新镜像以获得最新的框架版本和安全补丁

通过docker-stacks,您可以在几分钟内获得一个功能完整的深度学习环境,专注于模型创新而非环境搭建!✨

鲲鹏昇腾开发者社区是面向全社会开放的“联接全球计算开发者,聚合华为+生态”的社区,内容涵盖鲲鹏、昇腾资源,帮助开发者快速获取所需的知识、经验、软件、工具、算力,支撑开发者易学、好用、成功,成为核心开发者。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

项目地址: https://gitcode.com/gh_mirrors/do/docker-stacks

项目地址: https://gitcode.com/gh_mirrors/do/docker-stacks

所有评论(0)